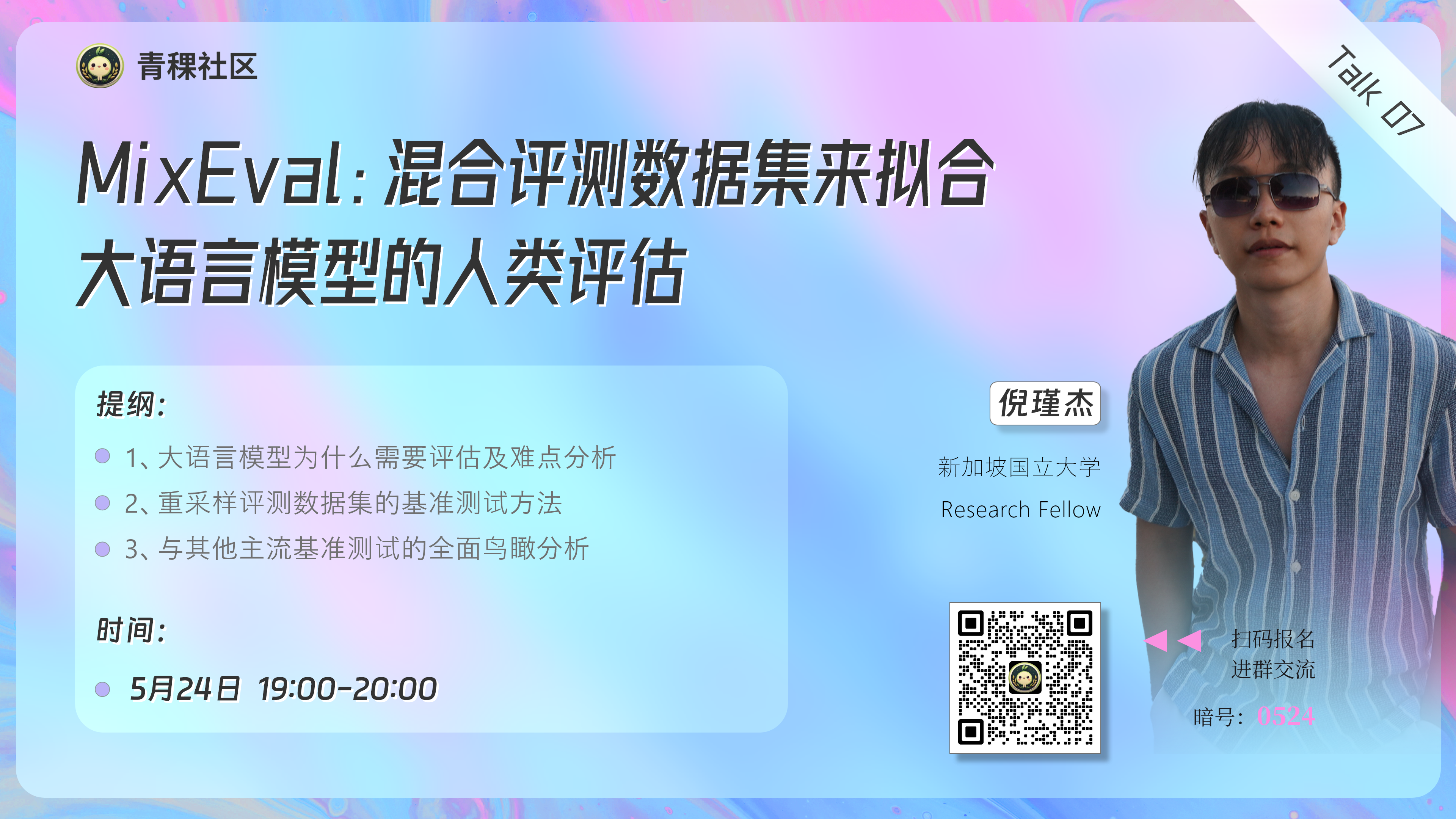

青稞Talk 07预告!MixEval:混合评测数据集来拟合大语言模型的人类评估

青稞Talk 07预告!MixEval:混合评测数据集来拟合大语言模型的人类评估

青稞 基准测试能够帮助从业者衡量大语言模型的能力。为了加速大语言模型的开发,一个能够快速评估大语言模型解决实际问题潜力的基准测试非常受欢迎。现有的基准测试往往无法反映现实世界用户查询的分布,或者需要耗时的人工干预。

基准测试能够帮助从业者衡量大语言模型的能力。为了加速大语言模型的开发,一个能够快速评估大语言模型解决实际问题潜力的基准测试非常受欢迎。现有的基准测试往往无法反映现实世界用户查询的分布,或者需要耗时的人工干预。

来自新加坡国立大学的倪瑾杰博士,在最新的研究成果中提出了一种基于真实数据构建的大型语言模型基准测试方法:MixEval。该方法弥补了可靠但昂贵的真实世界查询与快速但有偏差的实验室评估之间的差距。通过利用从网络上挖掘的用户查询,将其与现有基准测试中的类似查询匹配,MixEval

紧密地反映了真实用户查询的分布。

直播信息

分享嘉宾

倪瑾杰,新加坡国立大学Research Fellow。目前致力于大模型的高效训练,评估,以及多模态模型的训练。 南洋理工大学计算机科学博士,博士期间研究方向为语言模型。

主题提纲

MixEval:混合评测数据集来拟合大语言模型的人类评估

提纲:

1、大语言模型为什么需要评估及难点分析

2、重采样评测数据集的基准测试方法

3、与其他主流基准测试的全面鸟瞰分析

直播时间

5月24日(周五)19:00 - 20:00

参与方式

Talk

将在青稞·知识社区上进行,扫码对暗号:"0524",报名交流!