青稞Talk 09预告!具身多模态大模型的视觉表征预训练研究

青稞Talk 09预告!具身多模态大模型的视觉表征预训练研究

青稞 对于具身多模态模型而言,良好的视觉表征能力是其理解环境的基础,它的效果很大程度上依赖于视觉表征的质量和表现力,因此视觉表征预训练方法尤为重要。考虑到机器人数据的稀缺性,可利用大规模人类视频数据集来提取可泛化特征,用于视觉驱动的运动控制策略学习。

对于具身多模态模型而言,良好的视觉表征能力是其理解环境的基础,它的效果很大程度上依赖于视觉表征的质量和表现力,因此视觉表征预训练方法尤为重要。考虑到机器人数据的稀缺性,可利用大规模人类视频数据集来提取可泛化特征,用于视觉驱动的运动控制策略学习。

上海人工智能实验室青年研究员,OpenDriveLab具身智能方向负责人曾嘉等人在最新中稿 RSS 2024 的论文成果中,提出了一种视觉表征预训练方法LearningManipulation by Predicting Interaction (MPI)。

MPI 通过预测交互帧以及定位交互对象,使模型对于“如何交互”和“在哪里交互”有了更好地理解,增强了编码器捕捉操作过程中的行为模式及交互特征的能力。在多个下游机器人任务上,MPI 相比于 R3M、MVP、Voltron 等表征学习方法取得了显著的提升。

6月6日晚7点,青稞社区组织【青稞Talk】第九期,上海人工智能实验室青年研究员、OpenDriveLab具身智能方向负责人曾嘉博士,将直播分享《具身多模态大模型的视觉表征预训练研究》。

6月6日晚7点,青稞社区组织【青稞Talk】第九期,上海人工智能实验室青年研究员、OpenDriveLab具身智能方向负责人曾嘉博士,将直播分享《具身多模态大模型的视觉表征预训练研究》。

Talk信息

分享嘉宾

曾嘉,上海人工智能实验室青年研究员,OpenDriveLab具身智能方向负责人。博士毕业于上海交通大学。在国际知名会议与期刊RSS、CVPR、IEEE T-PAMI、IEEE JBHI等发表论文30余篇,其中一作及共一论文10篇。担任CVPR、ECCV、ICML等顶会审稿人。获中国博后基金面上资助、上海“超级博士后”。参与国家自然基金委项目、科技部2030新一代人工智能重大项目、上海市科委科研专项等。

主题提纲

具身多模态大模型的视觉表征预训练研究

提纲:

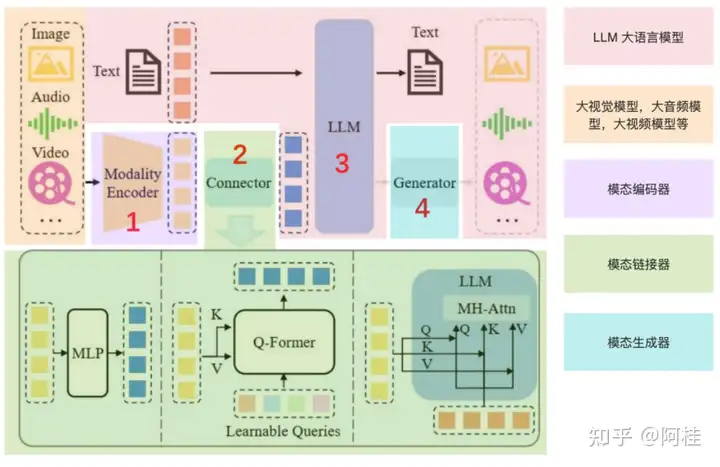

1、具身多模态大模型的研究分析

2、常见的视觉表征方法解析

3、面向机器人操作的视觉表征预训练方法 MPI

4、在下游机器人任务上的效果

直播时间

6月6日(周四)19:00 - 20:00

参与方式

Talk

将在青稞·知识社区上进行,扫码对暗号:"0606",报名交流!