青稞Talk 16预告!YOLO-World:基于视觉语言模型的实时开放词汇物体检测

青稞Talk 16预告!YOLO-World:基于视觉语言模型的实时开放词汇物体检测

青稞

在自然图像与视频目标检测与识别领域,传统方法通常在预定义类别的数据集上训练,无法识别数据集中未出现的目标类别,缺乏零样本检测能力,识别能力有限。

来自Tencent AI Lab、ARC Lab、Tencent PCG 以及华中科技大学的研究者们在 CVPR 2024 上提出了基于视觉语言建模的开放词汇YOLO-World模型,并探索针对YOLO检测器的大规模数据预训练方法,赋予 YOLO 模型零样本检测能力与语言理解能力,在推理速度和零样本检测精度上均领先先前工作。

YOLO-World模型目前已经在腾讯内部多项业务中落地,并与海外多家公司达成商业合作。

YOLO-World模型目前已经在腾讯内部多项业务中落地,并与海外多家公司达成商业合作。

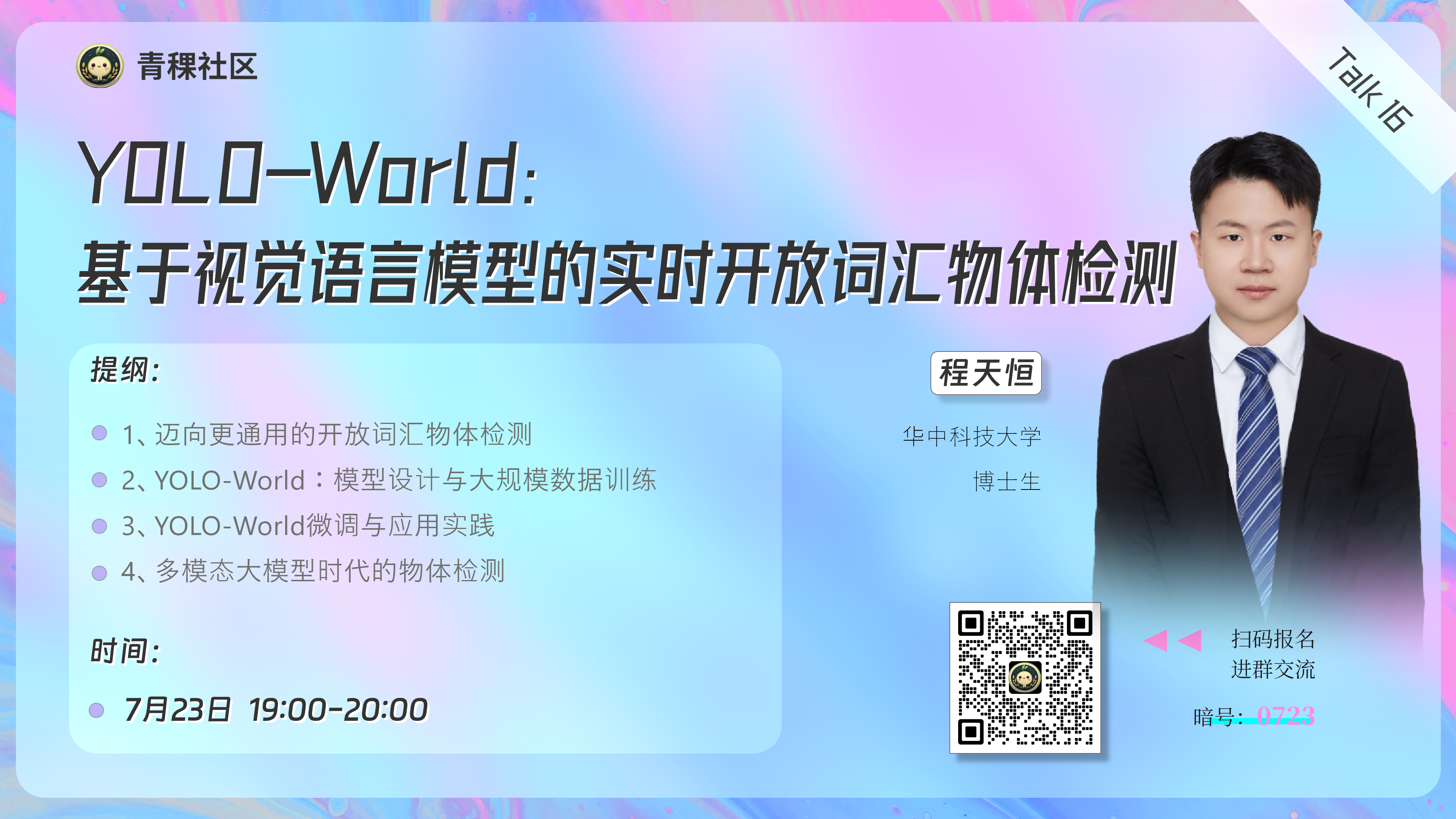

7月23日晚7点,青稞Talk第16期,华中科技大学博士生程天恒,将直播分享《YOLO-World:基于视觉语言模型的实时开放词汇物体检测》。

Talk信息

主讲嘉宾

程天恒,华中科技大学博士生;2019年获得华中科技大学(HUST)电子信息与通信专业的学士学位;研究兴趣包括计算机视觉、通用物体检测与分割以及多模态视觉模型,在人工智能与计算机视觉的顶级会议上发表学术论文11篇。

主题

YOLO-World:基于视觉语言模型的实时开放词汇物体检测

提纲

1、迈向更通用的开放词汇物体检测

2、YOLO-World:模型设计与大规模数据训练

3、YOLO-World微调与应用实践

4、多模态大模型时代的物体检测

直播时间

7月15日(周一)19:00 - 20:00

参与方式

Talk 将在青稞·知识社区上进行,扫码对暗号:" 0723 ",报名进群!