青稞Talk 22预告!通义多模态大模型mPLUG-Owl3是怎么炼成的?

青稞Talk 22预告!通义多模态大模型mPLUG-Owl3是怎么炼成的?

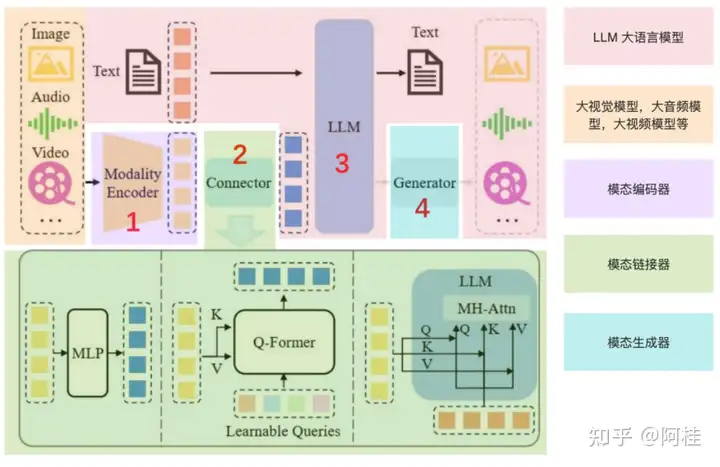

青稞支持自由格式的图文输入已然成为前沿多模态大模型的关键能力,然而如何高效地处理随之而来的长视觉内容同时准确建模图文交错输入成为了关键挑战。

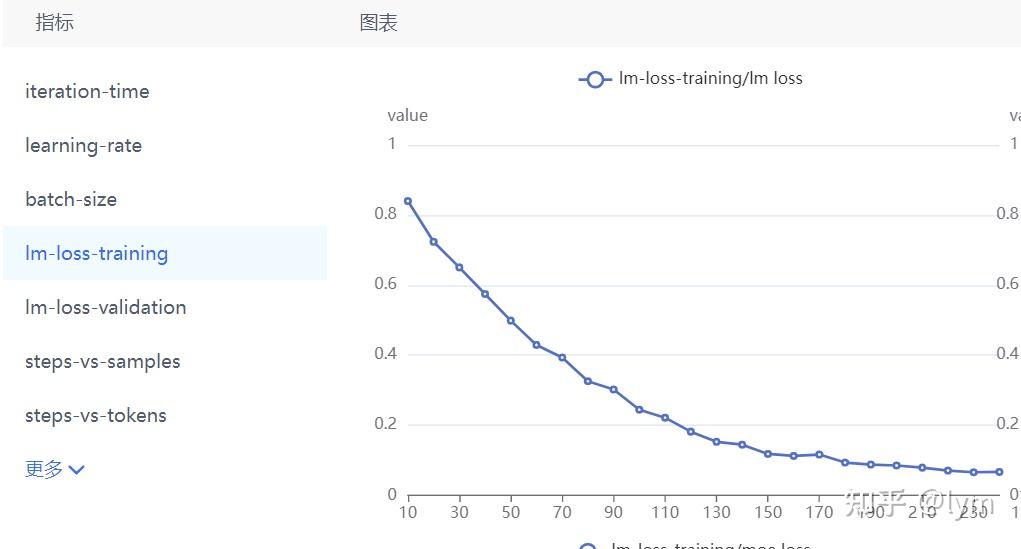

mPLUG-Owl3是阿里通义实验室mPLUG团队最新推出的通用多模态大模型,专门用来理解多图、长视频。其引入了一种全新的Hyper-Attention替代了传统的多模态序列拼接的范式,以达到成倍的效率提升。

Hyper-Attention能准确地建模任意图文交错格式下的多模态语义。这使得mPLUG-Owl3相比同尺寸模型不仅具备更低开销,在单图、多图和视频的测评中都能取得state-of-the-art的性能表现,并且在超长视觉内容输入的场景中具有显著的领先优势。

1 | Paper:mPLUG-Owl3: Towards Long Image-Sequence Understanding in Multi-Modal Large Language Models |

9月10日晚7点,青稞 Talk 第22期,阿里巴巴通义实验室高级算法工程师、华东师范大学博士叶加博,将直播分享《mPLUG-Owl3:探索长序列模型架构的通用多模态大模型》。

Talk信息

主讲嘉宾

叶加博,华东师范大学博士,阿里巴巴通义实验室高级算法工程师,参与通义多模态大模型mPLUG家族的研发,包含多模态底座mPLUG系列,多模态大语言模型mPLUG-Owl系列以及多模态文档理解大模型mPLUG-DocOwl系列。其中多模态文档理解工作mPLUG-DocOwl首次提出图像切分策略解决大模型高分辨率图像理解问题,成为前沿多模态大模型通用组件。

主题提纲

mPLUG-Owl3:探索长序列模型架构的通用多模态大模型

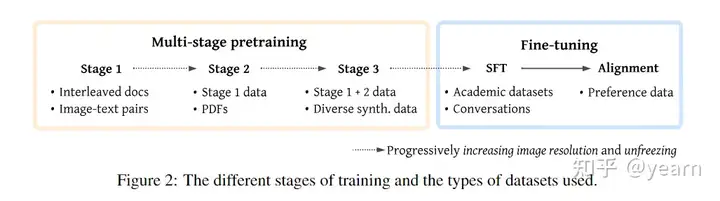

1、长视觉内容理解对多模态大模型的挑战 2、mPLUG-Owl3 模型架构及训练解析 - Hyper-Attention - 三阶段训练范式

3、mPLUG-Owl3 评估测试及应用实践

直播时间

9月10日(周二)19:00-20:00

参与方式

Talk 将在青稞·知识社区上进行,扫码对暗号:" 0910 ",报名进群!