行云集成电路创始人季宇:谈谈 AI 的泡沫

行云集成电路创始人季宇:谈谈 AI 的泡沫

青稞作者:季宇(mackler@知乎),行云集成电路的创始人

声明:本文只做分享,版权归原作者,侵权私信删除!

原文:https://zhuanlan.zhihu.com/p/718191220

最近关于AI泡沫的声音此起彼伏,NVIDIA的股价也跟着此起彼伏,看好和唱衰的都彼此站在长期预期和营收现状的角度争论不休好不热闹。大家说的都有道理,行业周期肯定会有,大模型也确实带来了巨大的想象空间。但有一个假设其实是问题的核心,但双方似乎都默认就应该是这样,那就是支撑大模型的计算机系统的成本就应该这么贵,无非是这么贵的成本到底还有没有大规模商业化机会的争论。

当然这种问题本身也是目前争议最大的话题,和以往一样,很多人都会讲的观点就也不再赘述,我的观点往往非常激进,也希望给大家带来不一样的视角,各位看官酌情食用。

AI大型机才是核心问题

AI大型机是我造的词,能更贴切地描述今天大家所使用的价格高昂的GPU服务器对行业产生的冲击。今天的AI产业以及GPU服务器和历史上的IBM大型机做过类比,IBM大型机可以小规模商业化,但无法支撑PC产业、互联网产业这种级别的繁荣。今天AI泡沫的争论,本质上是类似于探讨怎样用IBM大型机和工作站创造一个繁荣的PC产业和互联网产业。如果有惊为天人的应用创业者做出的下游应用可以让消费级用户愿意花费几十万甚至上百万购置大型机和工作站作为家用电脑,IBM的营收和估值甚至可能远超今天的NVIDIA,但这件事的难度极高,几乎杀死了下游应用的商业化空间。老黄最近几次公开演讲都是在鼓吹AI Factory,更是一种AI巨型机的概念,幻想未来大模型产业繁荣,到处都建设着这种AI巨型机支撑全世界从信息时代进入智能时代,从而使得NVIDIA的股价再数量级提高,站在NVIDIA的立场和视角当然无可厚非,但这比大型机作为PC产业的载体更加不现实。今天所有AI商业化探索过程中遇到的困境,都可以在“大型机作为PC产业和互联网产业的载体”这一假设下找到参考。

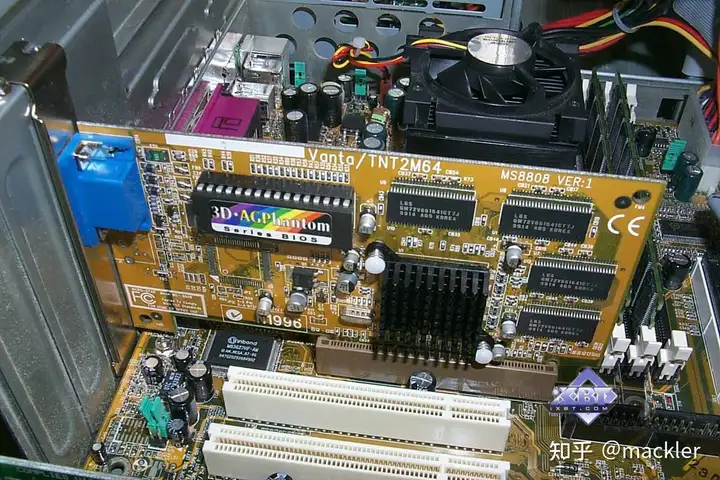

我们可以看到历史上真正催生出PC和互联网这种高度繁荣的产业的,是x86体系这种足够便宜、白盒化的兼容机开放体系。体系本身和公司无关,无论是IBM、Intel还是NVIDIA都是计算机行业非常伟大的公司,都是新体系的开拓者,都在不同时期带领计算机行业走到了前所未有的高度,包括今天的AI产业能发展到这样的高度,也是NVIDIA在综合性能极高的AI大型机上的不断投入,才催生出了今天的大模型。但要把产业真正带到高度繁荣的大模型时代,AI大型机的形态需要被白盒化的计算机体系革命掉。Intel如果在PC产业的前夜去做大型机,也一样会陷入到大型机体系的昂贵成本和更昂贵的售价中。今天即使是其他公司利润率低一些做AI大型机,也一样无法解决这个问题。今天关于AI的泡沫的争议,也都可以在“x86体系作为PC产业和互联网产业的载体”这一历史上的巨大繁荣下找到参考。

成本的量变和质变

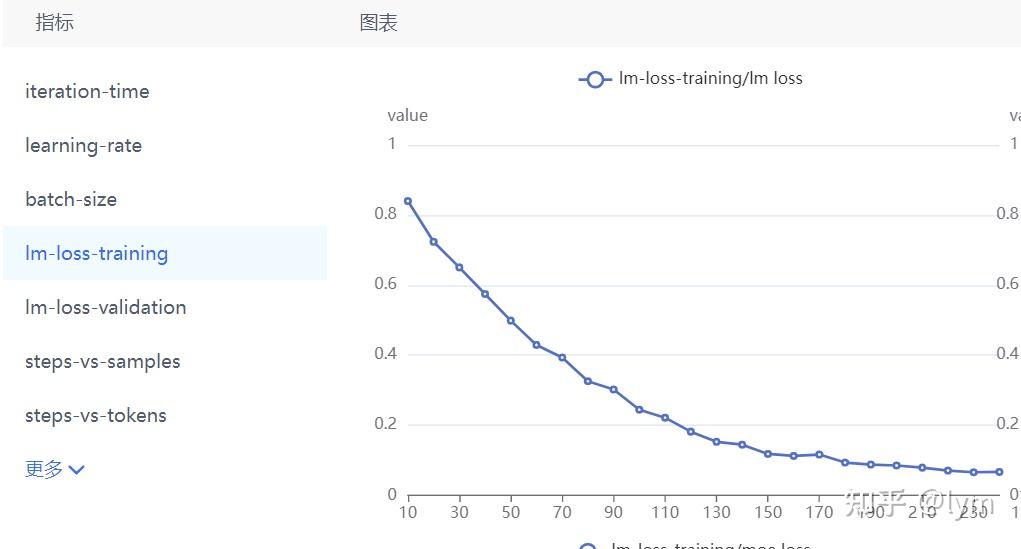

成本是一个很综合和细致的概念,今天行业里无数人努力降低大模型商业化的边际成本。哪怕Token价格一降再降,似乎还是难以找到能够建立行业信心的大规模商业化的超级应用,看起来似乎主要问题是商业化本身而不是成本。这里面有多方面的误区,一方面Token本身其实是个严重非标准化的东西,Token的模型质量、序列长度、领域覆盖、逻辑能力等茫茫多特征都是无法归一化的,单纯Token的成本实际上很难和产品打磨的需求相结合,而一个超级应用的产品打磨往往需要在今天AI技术能力和应用场景的需求上疯狂切香肠找Tradeoff,找到一个极致的平衡点。更重要的一方面是成本的量变和质变。

质变有几方面,一个是商业模型的转变。互联网最成功的地方在于塑造了羊毛出在猪身上的流量经济商业模式,从而摆脱了第一波互联网泡沫的困境,成功改造了整个社会形态。但今天大模型应用层面的大量尝试和互联网的流量经济仍然是截然不同的商业模型,大模型应用今天仍然逃脱不了算ROI,即用户量对应的边际成本和用户人均付费的折算。而互联网的流量经济内核是用户注意力和时间的争夺,互联网应用追求的不光是日活用户,更是每个用户每天要不断的用,把更多的时间和注意力用在这个应用上,再通过流量广告变现的逻辑实现巨额的收益。这是一种边际成本完全可以忽略的打法。这种商业模式上的转变也促成了对产品体验的极致优化,争夺的不是每次请求能让用户付费多少,而是用更极致的体验争夺用户的注意力,再通过流量广告悄无声息变现。无论今天Token价格战怎么打,如果把互联网产业真正规模数亿用户每天若干小时注意力的滔天流量打到大模型上,背后的成本始终是天文数字,无论如何掩盖不了AI大型机带来的困境。AI大型机的巨额投入会让应用尝试始终摆脱不了ROI的算计,没法扭转到流量经济的商业模式上。

另一个方面是试错门槛的问题。今天实际上计算机产业已经不知不觉偏离了人比机器贵的黄金时代, 方佳瑞师兄之前写的大模型Infra这些年,从黑铁时代到黄金时代再到白银时代其实就是今天这样一个机器比人贵的时代写照。在过去从PC产业之后漫长的三四十年黄金时代中,人的价值和创造力是很容易被放大的。几个程序员加上一个绝佳的商业点子,最多再加上数百万的启动资金就可以博一个千亿美金的超级应用,虽然失败率极高,但门槛足够低可以带来海量试错,总有那么几个能卷出来成为国民级应用。无数个人开发者也可以仅仅为解决自己的需求打造一些应用产品,就算不挣钱,维护成本也对个人没有任何压力。这一切都源自四十年前计算机进入一个组装机的白牌体系,体系带来的竞争使得计算机门槛大幅度降低,获得消费级市场的巨大繁荣,并进而衍生出更加繁荣的互联网产业,这其实就是白盒体系的力量,中间还有无数环节和商业模式可以进一步降低这个试错成本。

进一步讲,当机器的门槛低到消费级可以接受的成本,边际成本承担的商业模型也会发生变化,带来进一步的产业繁荣。当服务器可以便宜到十万块钱的时候,个人用户就可以在云上以每个月几十块钱的价格租云服务器,从而把试错门槛彻底击碎,最终大浪淘沙出无数精彩的互联网商业传奇。当最高端的大模型体验可以在一万块钱以下的消费级硬件上满足时,边际成本可以从云端应用端转移到消费者端,正如游戏和显卡的关系一般,像《黑神话》这类游戏,一次性精心打磨,零边际成本卖无数份,消费者自己买显卡获得画质体验。这些在AI大型机的体系上都是不现实的,消费者不可能花上百万买一台AI大型机,只为了享受AI带来的体验,也很难愿意花一万块钱买硬件只能拿到一个非常toy的AI体验。但如果计算机体系能支撑消费级可以接受的价格享受极致的AI体验,大模型产业会进一步进入一个类似软件行业零边际成本的超高速爆发期。

如果上述质变能够发生,大模型时代的确定性是极高的。

从第一性角度看,

AI带来的体验提升是确定性的

如果能够让边际成本重新回到流量经济的商业模型,争夺用户注意力本质上是用更革命性的体验取代旧的体验,这种体验的提升几乎是确定的,无论是搜索引擎、推荐系统还是聊天社交,如果不再算计ROI,找成本和体验的折中点,而是全力优化产品体验,都是一定能带来更好的用户体验的,从而颠覆掉原有的流量入口的。也许AI对话的体验不一定完全无死角碾压传统搜索引擎,但保持传统搜索引擎体验的基础上增加更多AI对话能力一定是确定性提升体验的。虽然今天很多产品体验不尽如人意,但如果试错门槛低到有海量人员都可以按照自己的产品体验的理念进行试错,AI带来的体验提升一定是确定性。更不用提AI带来的各种全新的入口级的机会,只是如果只有独角兽才能试错,大模型产业到来的确定性自然会降低。关于这一点,我就不再赘述,行业里面乐观派有大量描述的场景。

其实说了这么多,白盒化的计算机体系对成本和规格的要求其实及其变态,真的可行吗?

白盒化的计算机体系不是半导体的黑科技,也不是低配低价,而是软硬件边界更好的局部最优。这个概念可以很好地从IBM的大型机和白盒化的x86体系对比得到。Intel在上个世纪八十年代的时候,无论是半导体设计制造能力,还是在CPU的架构能力都远不如当时的IBM。IBM的Power处理器几乎是CPU的巅峰,无论在性能、可靠性等众多方面都是当之无愧的王者,当然带来的问题也就是贵,这甚至不是IBM利润率导致的贵,无论谁来,都没有什么黑科技能做一个便宜到可以颠覆掉IBM同时在性能、可靠性上可以匹敌的大型机,今天的AI大型机也是一样的。但x86体系并没有什么满足不了的需求,IBM的大型机以极高的可靠性使得金融交易等业务深度依赖大型机。x86的可靠性远不如大型机,但Google可以用大量廉价的x86服务器在软件系统层面做冗余,同样可以以极高的可靠性构建核心业务,甚至发展到今天带来的业务可靠性超过大型机。大量互联网企业最终同样在x86体系上建立了各种高度可靠的业务,也包括金融业务。

站在IBM大型机风头正盛的时候,CPU自然而然就是要高可靠性的,软件也是基于这样的假设去写的,这些软件自然也依赖硬件的高可靠性。但最终真正击败IBM的不是可靠性更好的计算机系统,也不是单纯更便宜的低可靠性计算机系统,而是软件系统不再需要CPU芯片那么极致的可靠性,进而不愿为那么极致的可靠性付出极高的溢价。

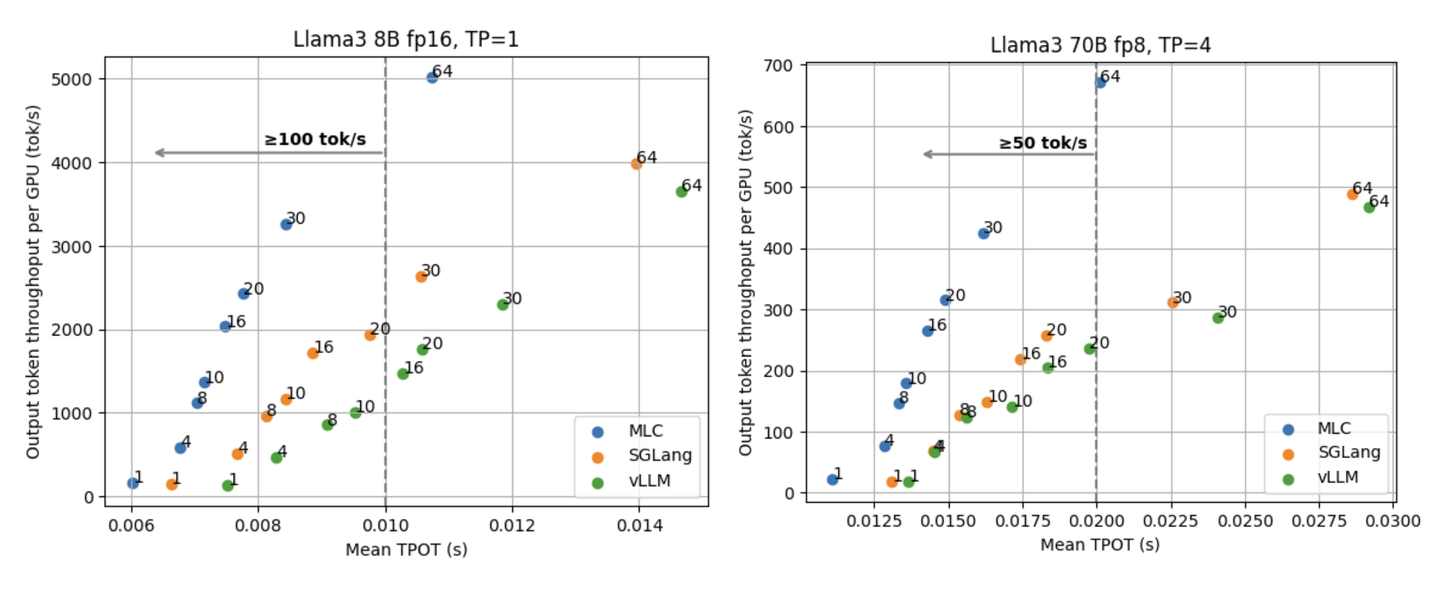

满足业务第一性需求的情况下,解构掉软件系统对高溢价硬件特性的需求。Kimi的推理引擎所采用的分离式系统架构(Mooncake (1): 在月之暗面做月饼,Kimi 以 KVCache 为中心的分离式推理架构)就展现了解构的巨大可能性。

进一步讲,从更第一性的角度看,NVLink这个把持着今天服务器形态、塑造了AI大型机的这些NVIDIA的私货特性,真的是大模型业务的第一性诉求吗?也许有人会说互联肯定是第一性需求,毕竟分布式系统,但今天全局层面千卡互联靠的是IB或者Ethernet提供的RDMA,而不是NVLink,NVLink只是一个局域互联。今天大量大模型应用在全局层面做的分布式算法必然是在RDMA域实现了可扩展性,而不是带宽更高的NVLINK域。换句话讲,其实全局层面的分布式算法并不第一性地依赖NVLink。这里面蕴含着更大的解构空间,可以真正意义上打破NVIDIA在服务器层面的定义权,实现计算机的重新白盒化。