SGLang、FlashInfer和MLC LLM向你发来一封邀请函~

SGLang、FlashInfer和MLC LLM向你发来一封邀请函~

青稞

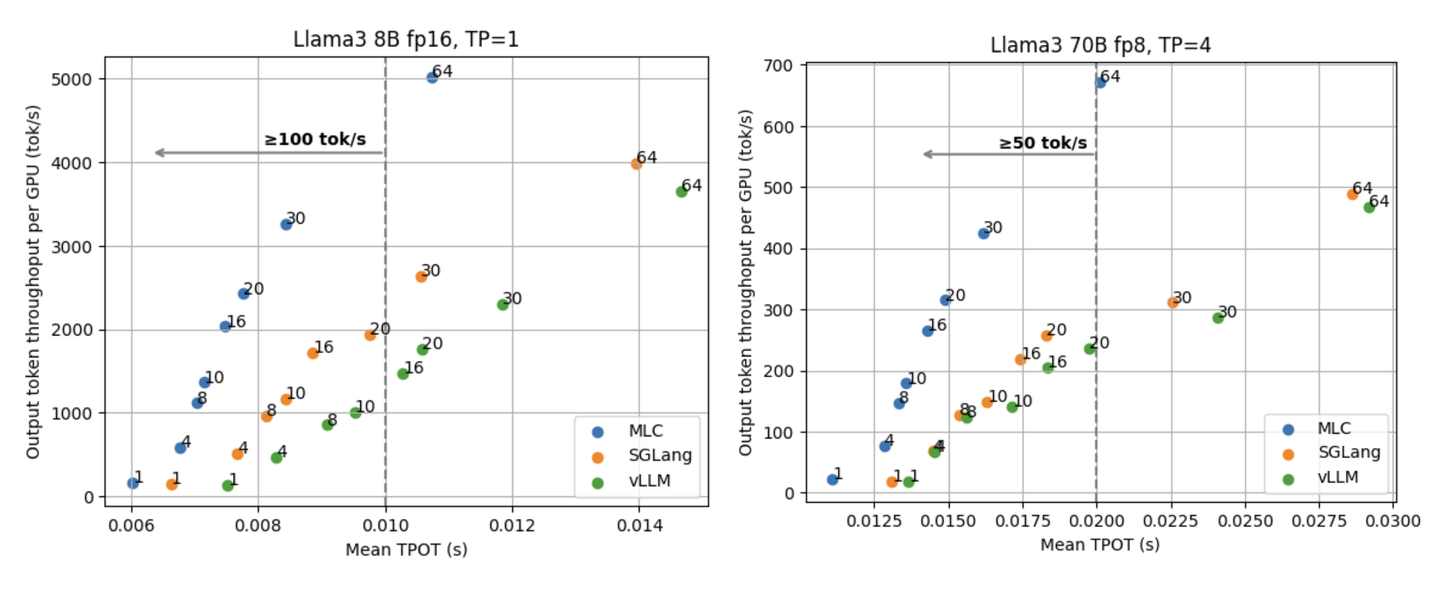

SGLang 是 LMSYS Org 团队于开源的一个用于 LLM 和 VLM 的通用服务引擎,采用 Apache 2.0 许可授权。它由纯 Python 编写,核心调度器只用了不到 4K 行代码就实现了,已被 LMSYS Chatbot Arena 用于支持部分模型、Databricks、几家初创公司和研究机构,产生了数万亿 token,实现了更快的迭代。

1 | https://github.com/sgl-project/sglang |

FlashInfer 是一个由 UW、CMU 和 OctoAI 的研究者们开源的一个大型语言模型库,可提供 LLM GPU 内核(例如 FlashAttention、SparseAttention、PageAttention、Sampling等)的高性能实现,提供了PyTorch API用于快速开发,以及header-only的C++ API,可以方便地集成到LLM服务引擎中。FlashInfer已被多个LLM服务框架所集成,包括 MLC-LLM (用于CUDA后端)和 SGLang。

1 | https://github.com/flashinfer-ai/flashinfer/ |

MLC LLM 是 CMU 助理教授、OctoML CTO 陈天奇等多位研究者共同开源的一个用于大型语言模型的机器学习编译器和高性能部署引擎。可以「在任何设备上编译运行大语言模型」,包括移动端(例如 iPhone)、消费级电脑端(例如 Mac)和 Web 浏览器。

1 | https://github.com/mlc-ai/mlc-llm |

10月17日7点,SGLang、FlashInfer和MLC LLM三个项目团队联合举办大模型高效部署与服务线上研讨会!三个项目的核心开发者们将共同分享、探讨他们在LLM高效部署和服务方面的不同见解。

议程

- 7:00 - 7:45 SGLang

演讲嘉宾:尹良升、郑怜悯、鲍科

分享主题:SGlang 中的低CPU 开销调度、Deepseek MLA 优化及 JSON 高效解码 - 7:50 - 8:35 FlashInfer

演讲嘉宾:叶子豪

分享主题:高性能LLM Serving的 Kernel 生成 - 8:40 - 9:30 MLC LLM

演讲嘉宾:赖睿航、董易昕、陈天奇

分享主题:通用 LLM 部署、低延时服务及基于 Grammar 的快速解码

参与方式

扫码对暗号:" ELLM ",报名进群!