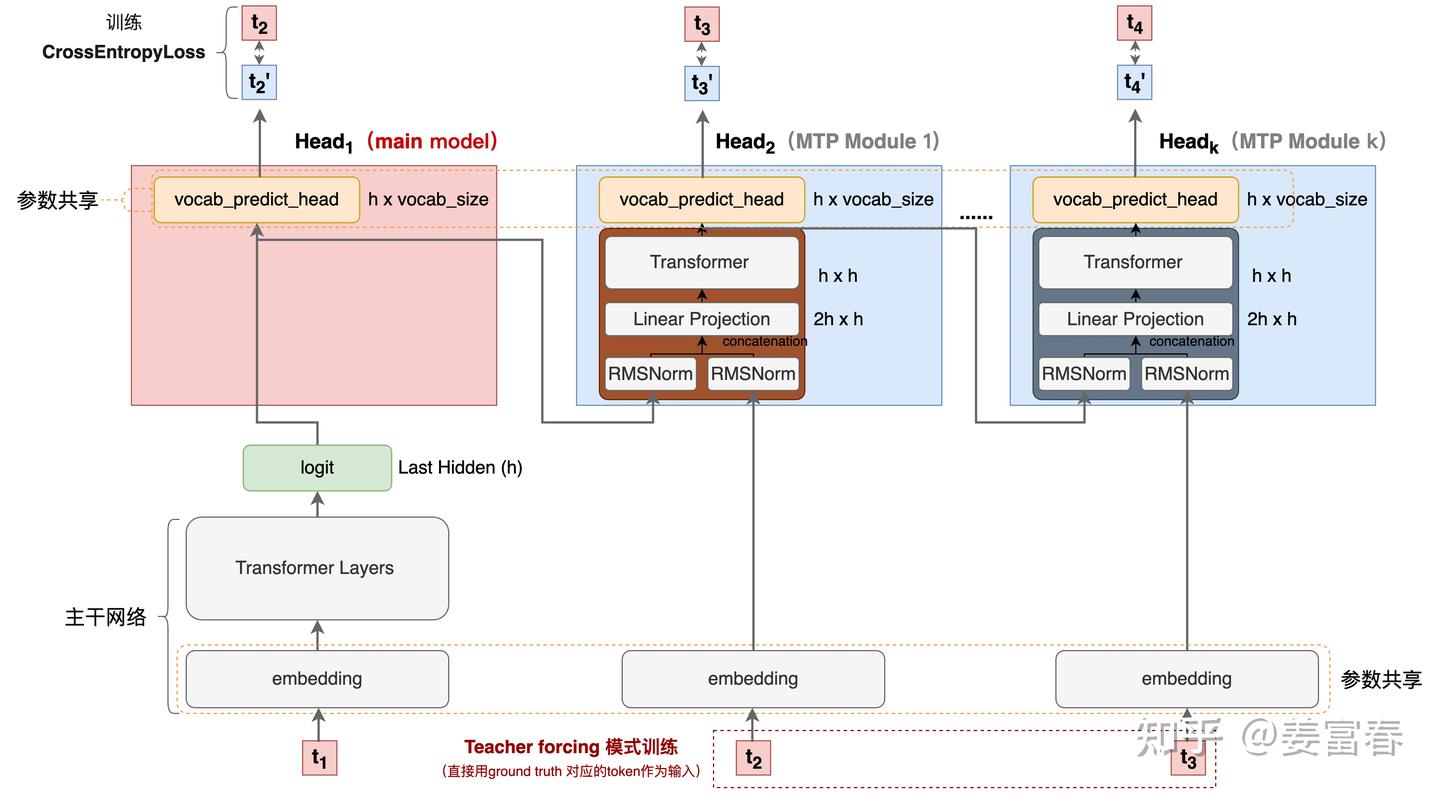

MiniMax-01技术报告解读

MiniMax-01技术报告解读

青稞作者:北方的郎 原文:https://zhuanlan.zhihu.com/p/18384965809 >>加入青稞AI技术交流群,与青年研究员/开发者交流最新AI技术

刚刚MiniMax发布了MiniMax-01,简单测试了效果,感觉不错。于是又把它的技术报告看了一下。这种报告看多了,就会多一个毛病,越来越觉得自己也能搞一个。 O

这篇文章我觉得最有意思的一句是对数据质量的强调“低质量数据在训练超过两个epoch后性能显著下降,而高质量数据可以有效地训练多达四个epoch”

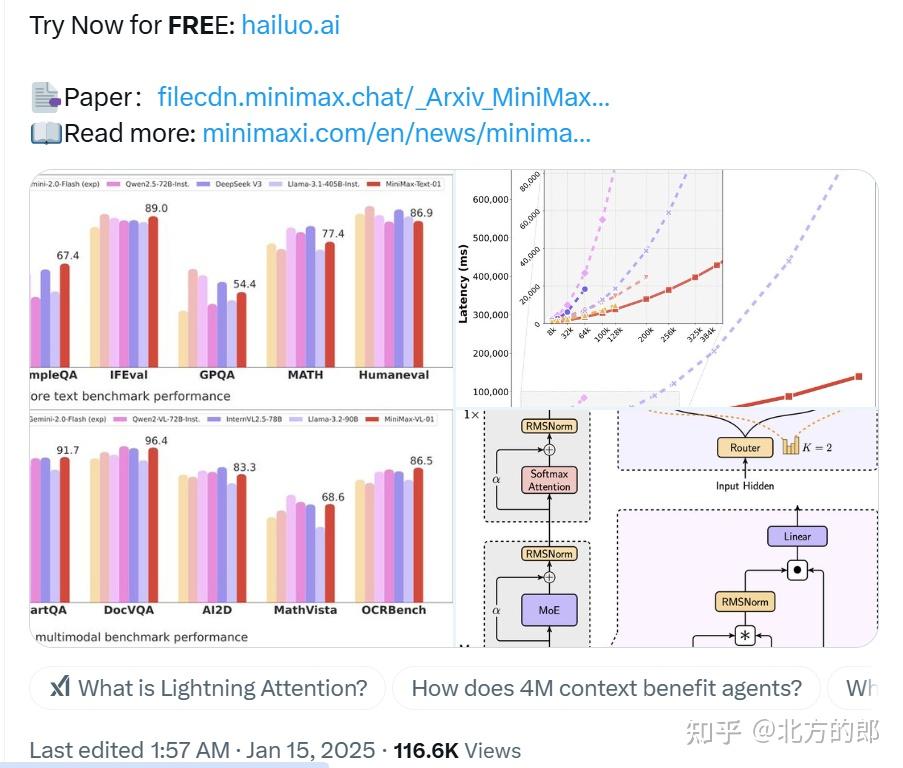

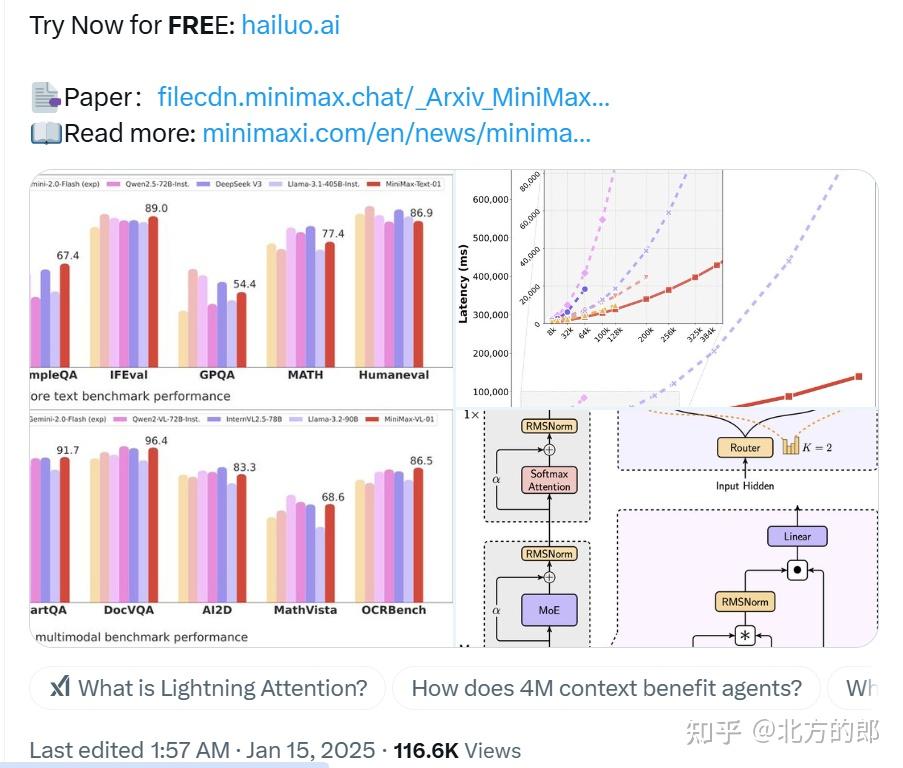

MiniMax-01系列模型通过创新的Lightning Attention和专家混合(Mixture of Experts, MoE)架构,实现了在长上下文处理上的突破性进展。

1 | Paper:MiniMax-01: Scaling Foundation Models with Lightning Attention |

1. 引言

近年来,大型语言模型(LLM)和视觉语言模型(VLM)在知识问答、复杂推理、数学、编程和视觉语言理解等任务上取得了显著进展。然而,大多数模型的上下文窗口长度通常在32K到256K token之间,这在实际应用中往往显得捉襟见肘。无论是处理一本专业书籍、协助整个编程项目,还是通过多示例学习最大化上下文学习的潜力,现有的上下文长度都显得不足。

过去两年中,上下文窗口的扩展主要依赖于更强大的GPU和更好的I/O感知的softmax注意力实现。然而,进一步扩展这些窗口面临着巨大的挑战,这源于Transformer架构固有的二次计算复杂度——随着长度的增加,计算需求远远超过硬件能力的提升速度。为了应对这一挑战,研究人员提出了多种方法来减少注意力机制的计算复杂度,包括稀疏注意力、线性注意力、长卷积、状态空间模型和线性RNN等。尽管这些方法在理论上具有潜力,但在商业规模的模型中应用有限。

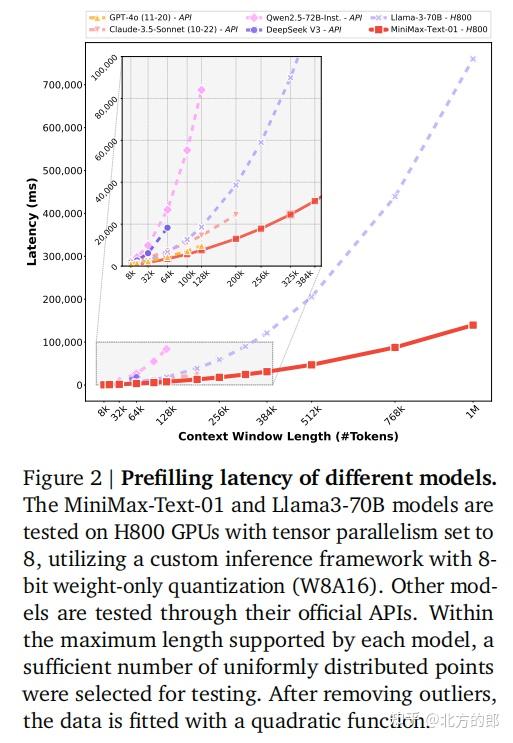

MiniMax-01的目标是构建一个与领先商业模型性能相当,但上下文窗口长度提升一个数量级的模型。这一雄心勃勃的目标需要在网络架构、数据和计算之间找到平衡。MiniMax-01采用了混合架构,结合了闪电注意力和softmax注意力,并通过专家混合(MoE)架构最大化参数和计算能力,最终实现了在单台机器上处理超过100万token的能力。

2. 模型架构

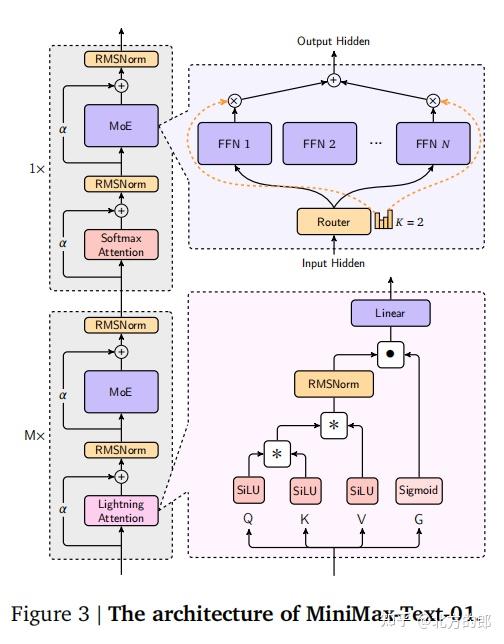

MiniMax-01的架构设计旨在在有限的资源下实现最佳性能,并更好地处理长序列。为了实现这一目标,模型采用了专家混合(MoE)方法,并尽可能使用线性注意力(Linear Attention)代替传统的softmax注意力。以下是对模型架构的详细解析。

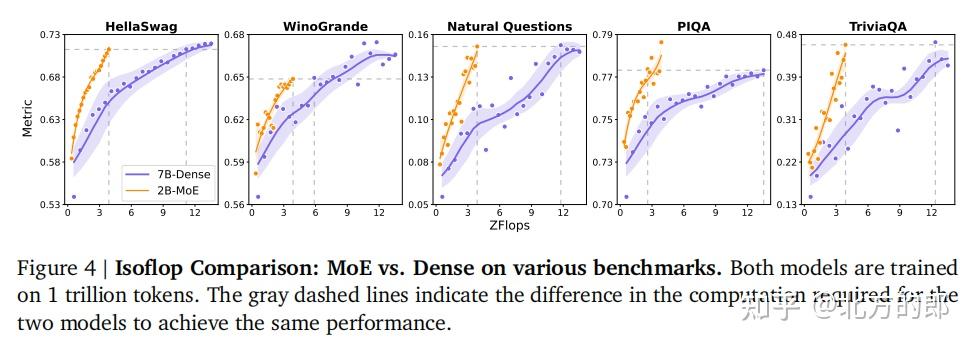

2.1 专家混合(MoE)

专家混合(Mixture of Experts, MoE)是一种通过将多个前馈网络(FFN)专家组合在一起,每个token被路由到一个或多个专家的架构。这种设计不仅增强了模型的扩展性,还提高了计算效率。MiniMax-01的MoE架构包含32个专家,总参数量达到4560亿,每个token激活的参数量为459亿。

在MoE的训练过程中,每个专家都有一个容量限制,指定其可以处理的最大token数量。一旦达到容量,任何额外的token将被丢弃。为了确保负载平衡,MiniMax-01引入了一种全局路由策略,通过同步不同专家并行组(EP)中的token分布,减少了token丢弃率,从而提高了训练的稳定性。

2.2 线性注意力(Linear Attention)

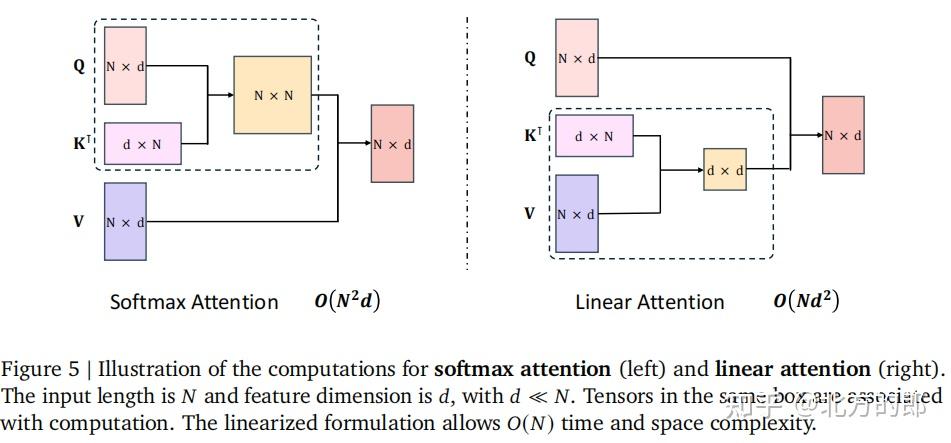

线性注意力(Linear Attention)通过“右积核技巧”将传统的二次计算复杂度转化为线性复杂度,显著降低了长序列处理的计算负担。具体来说,线性注意力通过递归更新键值矩阵的乘积,避免了重复计算整个注意力矩阵,从而在推理过程中保持了恒定的计算复杂度。

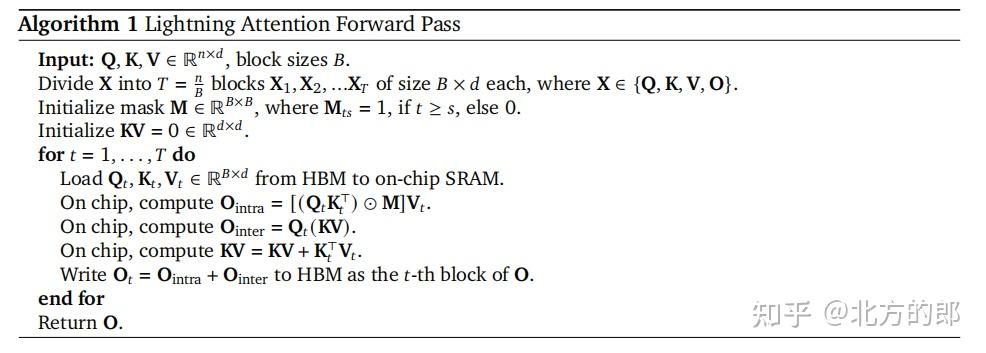

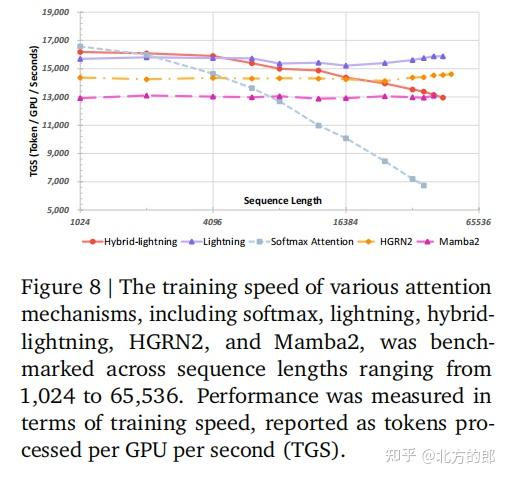

MiniMax-01采用了Lightning Attention,这是一种I/O感知的线性注意力实现。Lightning Attention通过分块计算避免了因果语言建模中的累积求和操作,从而实现了理论上的线性复杂度。具体来说,Lightning Attention将注意力计算分为块内计算和块间计算两部分,块内计算使用左积,块间计算使用右积。这种分块策略确保了整体计算复杂度保持线性。

Lightning Attention的核心创新在于其分块技术。通过将查询(Q)、键(K)和值(V)矩阵沿行维度划分为多个块,Lightning Attention能够在每个块内独立计算注意力分数,从而避免了全局累积求和操作。这种设计不仅提高了计算效率,还使得模型能够处理更长的序列。

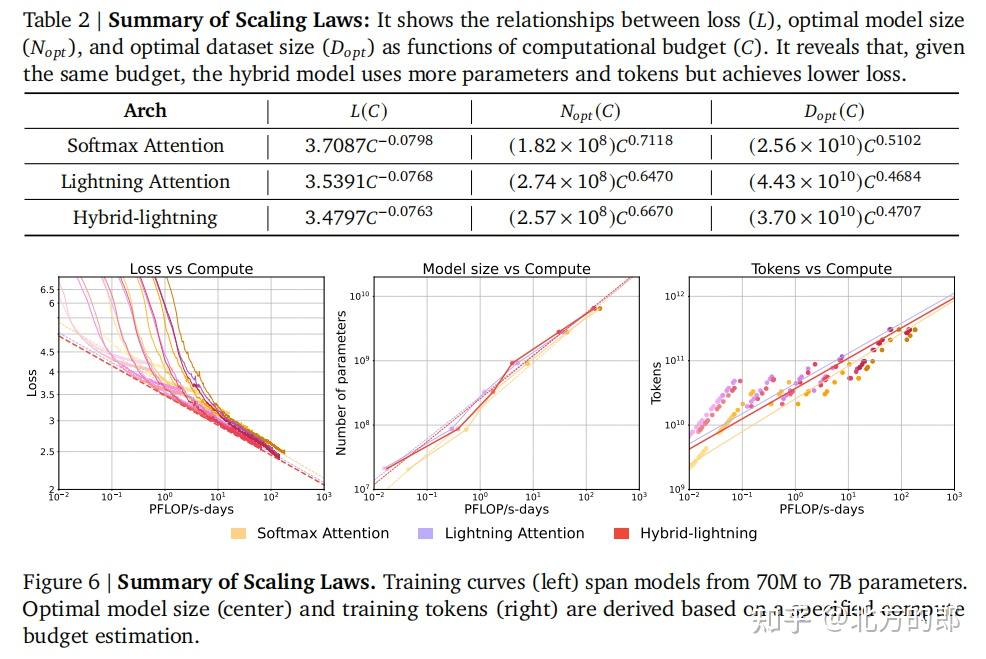

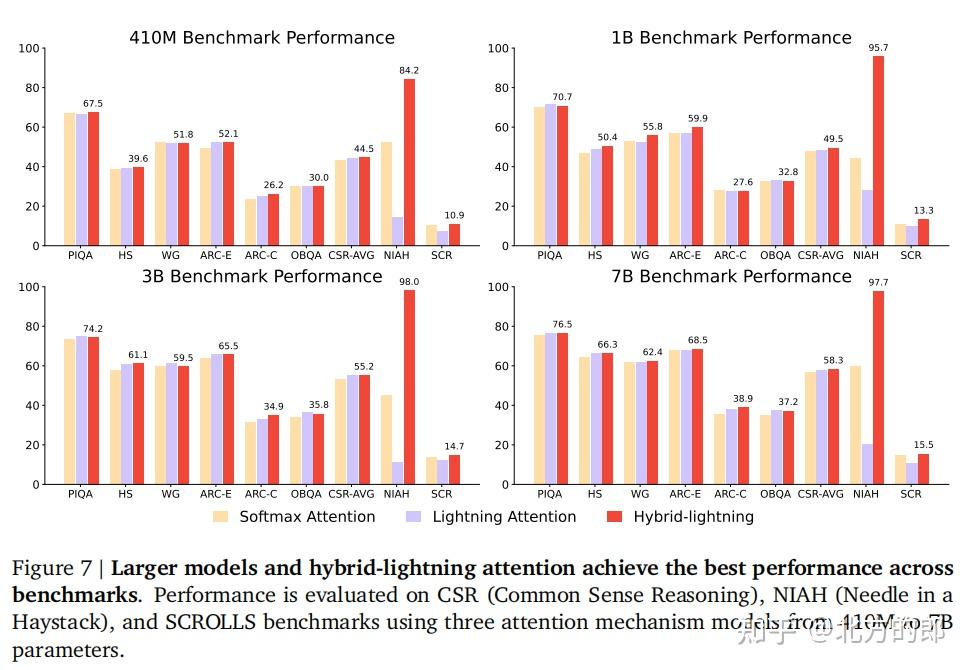

2.3 混合架构

MiniMax-01的最终架构结合了线性注意力和softmax注意力,每7个线性注意力层后跟随一个softmax注意力层。这种混合架构不仅提升了模型的推理能力,还在长上下文任务中表现出色。

具体来说,MiniMax-01的架构遵循Transformer风格,每个块包含一个通道混合器(注意力块)和一个特征混合器(MLP块)。通道混合器有两种类型:Lightning Attention和softmax注意力。特征混合器则是一个包含多个前馈网络(FFN)的MoE。为了确保MoE块的负载平衡,MiniMax-01提出了一种新的负载平衡策略,称为全局路由器(Global Router),该策略旨在保持训练的稳定性。

在MiniMax-01的最终架构中,线性注意力和softmax注意力机制以结构化模式集成。具体来说,每7个线性注意力层后跟随一个softmax注意力层,总共有80层。每个注意力模块由64个头组成,每个头的维度为128。softmax注意力层采用组查询注意力(GQA),组大小为8。旋转位置嵌入(RoPE)应用于一半的注意力头维度,基础频率设置为10,000。模型的隐藏大小配置为6144,每层包含32个专家,采用top-2路由策略。每个专家内的前馈网络隐藏维度为9216。

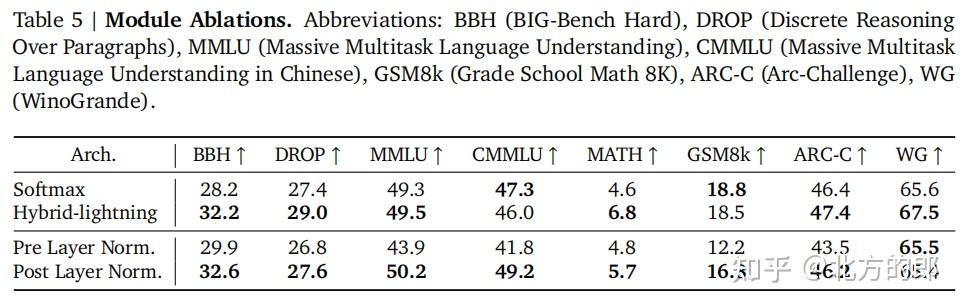

2.4 模块消融实验

为了验证MoE架构中模块选择的有效性,MiniMax-01进行了两组消融实验:

- Lightning Attention与softmax注意力的比较:

在28亿参数的MoE模型中,每8个连续层中的前7层用Lightning Attention替换softmax注意力。实验结果表明,替换部分softmax注意力层可以提高大多数基准测试的准确性。

- 前层归一化与后层归一化的比较:

MiniMax-01在93亿激活参数的模型上进行了实验,比较了前层归一化(PreNorm)和后层归一化(PostNorm)的效果。实验结果表明,PostNorm在所有评估指标上均优于PreNorm。

通过这些实验,MiniMax-01进一步验证了其架构设计的有效性,确保了模型在长上下文任务中的优异表现。

3. 计算优化

MiniMax-01的计算优化是其能够在数百亿参数的模型上实现高效训练和推理的关键。为了应对大规模模型训练和长上下文处理中的挑战,MiniMax-01在计算优化方面进行了多项创新,主要集中在三个方面:专家混合(MoE)架构的优化、长上下文处理的优化以及Lightning Attention推理的优化。以下是对这些优化策略的详细解析。

3.1 MoE优化

专家混合(MoE)架构的主要挑战在于减少训练过程中的通信开销,尤其是在使用全对全(all-to-all, a2a)通信时。MoE模型的专家参数通常分布在多个GPU上,通信开销会显著影响训练效率。

MiniMax-01通过以下策略优化了MoE架构:

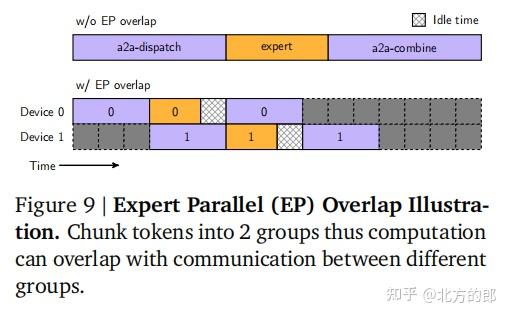

- 基于token分组的重叠计算:

MiniMax-01设计了一种基于token分组的重叠计算方案,将a2a通信与不同专家组的计算重叠进行。具体来说,a2a通信在专家并行(EP)通信组内执行,并与不同专家组的token处理重叠。为了确保通信结果的正确性,每个进程组(ProcessGroup)按顺序执行通信操作,从而避免了不同组之间的通信重叠。这种策略显著提升了性能,但同时也带来了计算强度与内存使用之间的权衡。

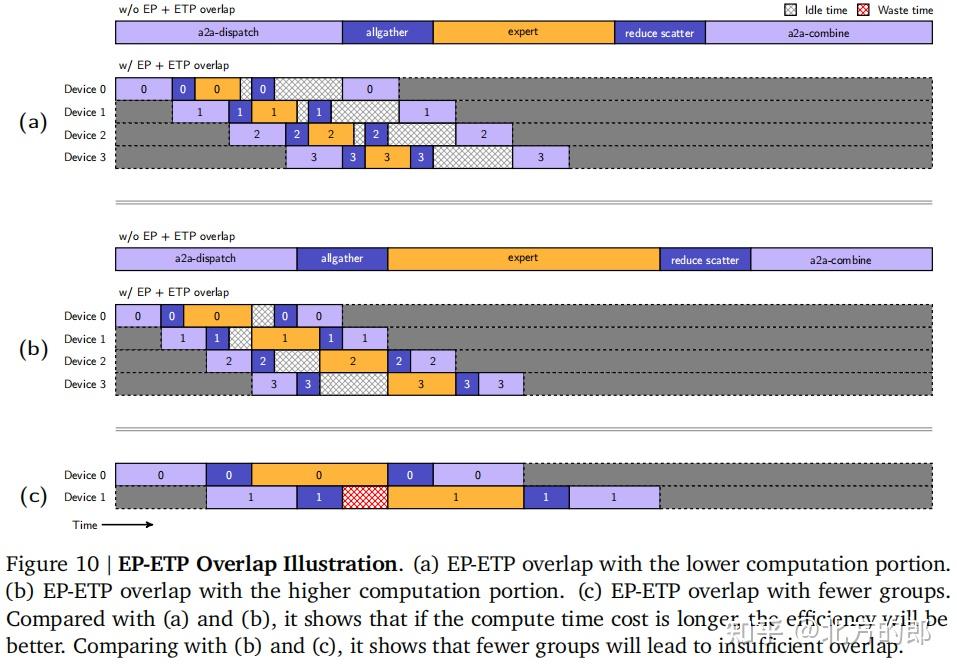

- 专家张量并行(ETP)与专家数据并行(EDP):

为了进一步优化MoE的训练效率,MiniMax-01引入了专家张量并行(Expert Tensor Parallel, ETP)和专家数据并行(Expert Data Parallel, EDP)策略。ETP负责管理专家权重的分区,而EDP则负责相同专家的数据并行。通过这种设计,MiniMax-01能够完全解耦MoE组件与非MoE组件的并行策略,从而灵活配置ETP以实现内存使用和计算强度之间的最佳平衡。

- EP-ETP重叠策略:

为了最大化网络资源和计算资源的利用率,MiniMax-01设计了EP-ETP重叠策略。该策略通过延长计算时间,增加了通信与计算重叠的机会,从而显著提升了整体性能。实验表明,这种优化策略将MoE组件的纯通信开销减少了50%,显著提高了训练效率。

3.2 长上下文优化

MiniMax-01的目标是支持至少100万token的上下文窗口,这对模型的训练和推理提出了极高的要求。为了应对这一挑战,MiniMax-01在长上下文处理上进行了多项优化。

- 数据打包(Data-Packing):

在长上下文训练中,传统的填充(padding)方法会导致大量计算浪费。MiniMax-01采用了数据打包技术,将不同样本沿序列维度连接,从而减少了计算浪费。这种格式在训练过程中最小化了计算资源的浪费,尤其是在100万token的上下文窗口下,显著提升了计算效率。

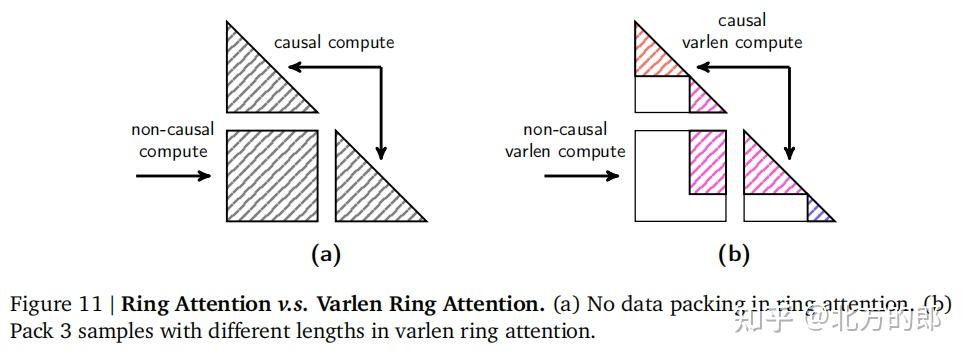

- 变长环形注意力(Varlen Ring Attention):

对于softmax注意力,环形注意力(Ring Attention)算法提供了一种有效的数据分区方法,能够实现无限扩展。然而,现有的环形注意力实现并未针对数据打包格式进行优化。MiniMax-01重新设计了环形注意力算法,提出了变长环形注意力(Varlen Ring Attention),直接在整个序列上应用环形注意力机制,避免了传统方法中的过度填充和计算浪费。

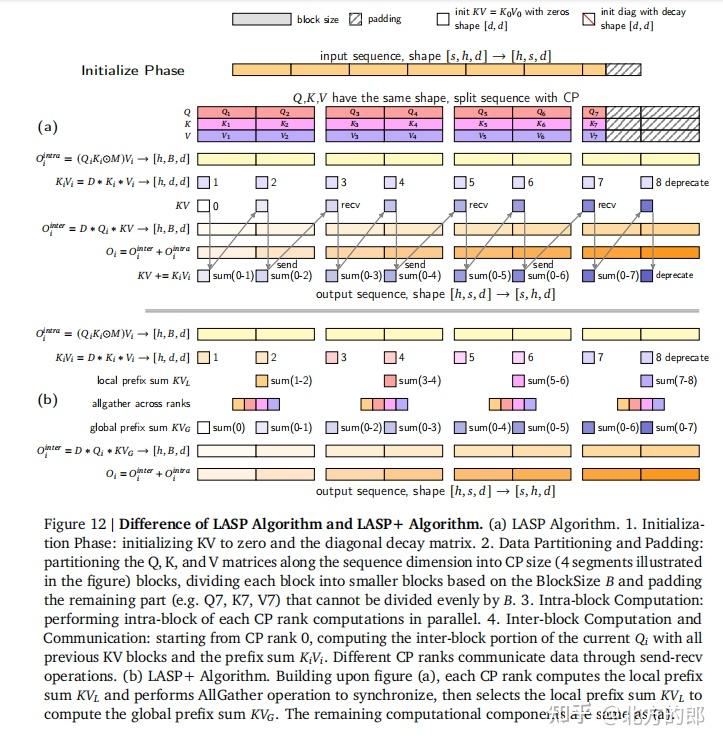

- 改进的线性注意力序列并行(LASP+):

对于Lightning Attention,MiniMax-01改进了线性注意力序列并行(Linear Attention Sequence Parallelism, LASP)算法。原始的LASP算法要求所有计算节点(CP rank)通过发送-接收操作交换中间键值(KV)块结果,这导致了计算节点之间的顺序依赖,限制了并行计算的效率。MiniMax-01提出的LASP+算法通过以下步骤消除了这种依赖:

- 本地前缀和计算:每个计算节点独立计算其本地前缀和(KV_t)。

- 全局同步:通过AllGather操作同步所有节点的信息。

- 前缀和计算:每个节点选择特定的CP rank的KV_t来计算全局前缀和(KV_G)。

这种优化将串行计算转化为并行计算,显著提升了训练效率。实验表明,LASP+算法的计算速度可以达到原始LASP算法的1/N_pen(N_pen为并行计算节点数),同时AllGather操作的开销极小。

- 变长特征支持:

MiniMax-01进一步为LASP+算法引入了变长特征支持,以有效管理数据打包格式。具体来说,每个输入在批处理中被填充到预定义的块大小(256),然后按顺序连接。这种设计使得模型能够处理具有不同token长度的批处理输入,同时最大限度地利用GPU的并行计算能力。

3.3 Lightning Attention推理优化

Lightning Attention的初始实现主要面向研究,尚未完全适用于实际推理场景。为了优化推理效率,MiniMax-01在Lightning Attention的推理过程中实施了四项优化策略。

- 批处理内核融合:

在预填充阶段,MiniMax-01对Q、K、V张量的处理进行了内核融合,包括序列维度的填充、分块、内部布局调整和衰减值计算。在解码阶段,MiniMax-01对KV计算和前缀KV缓存的更新进行了内核融合。这些优化减少了中间结果的存储和内存访问操作,显著提升了内存访问效率,并在短文本输入场景下将端到端延迟降低了10%。

- 分离预填充和解码执行:

Lightning Attention的长序列计算主要围绕块内和块间计算的区分。然而,在推理任务中,解码阶段的token长度通常为1,这种设计并不最优。MiniMax-01提出了一种策略,将长度为1的token与长度大于1的token分开处理,使用两个不同的内核,并通过两个独立的CUDA流并行调度这些内核。这种策略显著提升了计算效率,尤其是在混合输入场景下。

- 多级填充:

通过在Q、K、V张量的序列维度上应用填充,MiniMax-01将块内和块间计算分解为多个相同的矩阵乘法。这种分解与StridedBatchedMatmul接口无缝对接,从而最大限度地利用了并行处理能力。为了进一步减少冗余计算,MiniMax-01引入了额外的分段选项(32、64和128),根据当前输入序列长度动态选择计算规模。

- StridedBatchedMatmul扩展:

MiniMax-01利用NVIDIA cuBLAS库中的cublasGemmStridedBatchedEx函数管理StridedBatchedMatmul操作,确保了跨不同硬件架构的高性能和多功能性。此外,MiniMax-01正在实施更广泛的内核融合策略,以进一步提升Hopper GPU的计算效率。

通过这些优化,MiniMax-01在H20 GPU上的端到端推理任务中实现了超过75%的模型浮点运算利用率(MFU)。在MiniMax-Text-01和MiniMax-VL-01的推理中,softmax注意力在102.4万token序列长度下占用了95%的延迟,而Lightning Attention的实现仅占用了不到12%的延迟。

4. 预训练

MiniMax-01的预训练过程是其能够在长上下文任务中表现出色的关键。为了构建一个强大的基础模型,MiniMax-01在数据选择、数据格式优化、数据混合策略以及长上下文扩展等方面进行了精心设计和优化。以下是对预训练过程的详细解析。

4.1 数据

MiniMax-01的预训练数据是其成功的基础。为了确保模型的高性能,MiniMax-01在数据质量、数据格式和数据混合策略上进行了多项创新。

4.1.1 预训练语料库

MiniMax-01的预训练语料库涵盖了多种来源,包括学术文献、书籍、网页内容和编程代码。为了确保数据的高质量,MiniMax-01采用了以下策略:

- 数据质量增强:

通过结合规则清洗和去重程序,MiniMax-01对文档质量进行了严格评估。模型使用前一代MiniMax模型作为奖励标签器,评估文档的连贯性、简洁性、教育价值、帮助性、知识丰富性和类别相关性。最终,MiniMax-01聚焦于三个关键维度:知识深度、实用帮助性和类别分布,同时将其他指标作为次要验证指标。

- 数据格式优化:

对于网页和书籍内容,MiniMax-01在提取和清洗后直接使用,无需进一步格式化。对于对话和问答数据,MiniMax-01采用了嵌套文档格式,使用灵活的模板来平衡自然理解与结构一致性。这种设计确保了模型在多种交互模式下的泛化能力。

- 数据混合策略:

MiniMax-01开发了一种复杂的数据分布调整方法,基于知识深度和帮助性等质量指标进行采样权重调整。实验表明,完全剔除低质量内容可能会对下游任务性能产生负面影响,因此MiniMax-01采用了平衡采样策略,确保高质量内容的优先性,同时保留多样化的类别。

4.1.2 分词

MiniMax-01采用了字节级字节对编码(Byte-level Byte Pair Encoding, BPE)进行分词,词汇表大小为20万。为了提升多语言内容的压缩效率,MiniMax-01对多语言内容进行了上采样。

4.1.3 数据实验

为了系统评估预训练数据质量、格式和组成的影响,MiniMax-01进行了广泛的数据消融实验。通过训练多个小规模MoE模型,MiniMax-01能够隔离和测量单个数据属性的影响,同时保持计算效率。

4.1.4 重复数据的影响

重复数据对模型性能和泛化能力有显著的负面影响。MiniMax-01引入了重复感知实验框架,通过全局去重和按训练计划下采样文档,确保数据效率与最终训练阶段一致。实验表明,低质量数据在训练超过两个epoch后性能显著下降,而高质量数据可以有效地训练多达四个epoch。

4.2 训练策略

MiniMax-01的训练策略是其能够在长上下文任务中表现出色的关键。通过精心设计的初始化、学习率调度和长上下文扩展策略,MiniMax-01成功将训练上下文长度扩展到100万token。

4.2.1 初始预训练

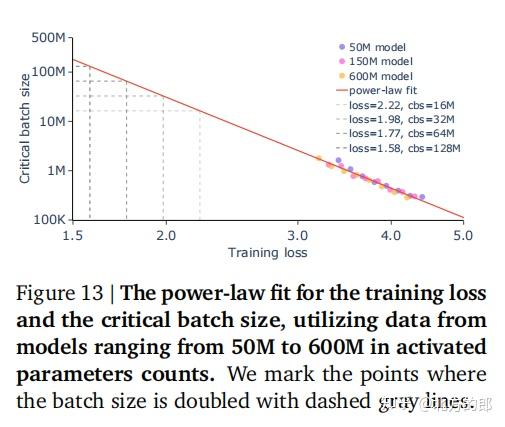

MiniMax-01使用Xavier初始化方法初始化所有模型参数,DeepNorm的缩放因子设置为α=(2N)0.25和β=(8N)-0.25,其中N为层数。模型采用AdamW优化器,β1=0.9,β2=0.95,权重衰减为0.1。训练序列长度为8192,批量大小从初始的1600万逐步增加到7900亿token时的6400万,最终在4.7万亿token时增加到1.28亿。

4.2.2 长上下文扩展

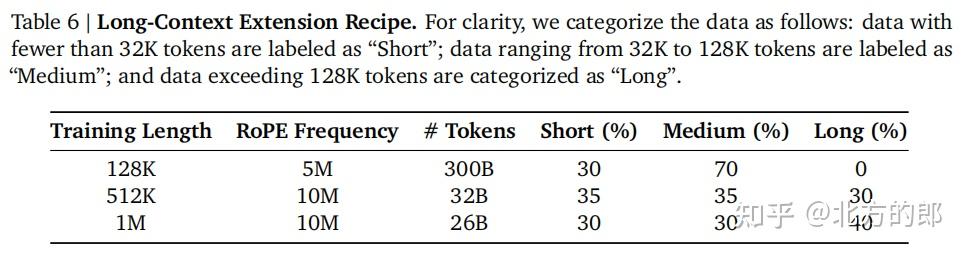

MiniMax-01通过三阶段训练过程,逐步将模型的训练上下文长度扩展到100万token。每个阶段的训练数据混合、RoPE基础频率和训练长度如下表所示:

在每个阶段的最后20%训练周期中,MiniMax-01混合了10%的高质量长上下文问答数据,以确保模型在长上下文任务中的表现。为了缓解分布变化带来的不稳定性,MiniMax-01采用了源特定权重的线性插值方法,逐步将数据分布过渡到目标分布。

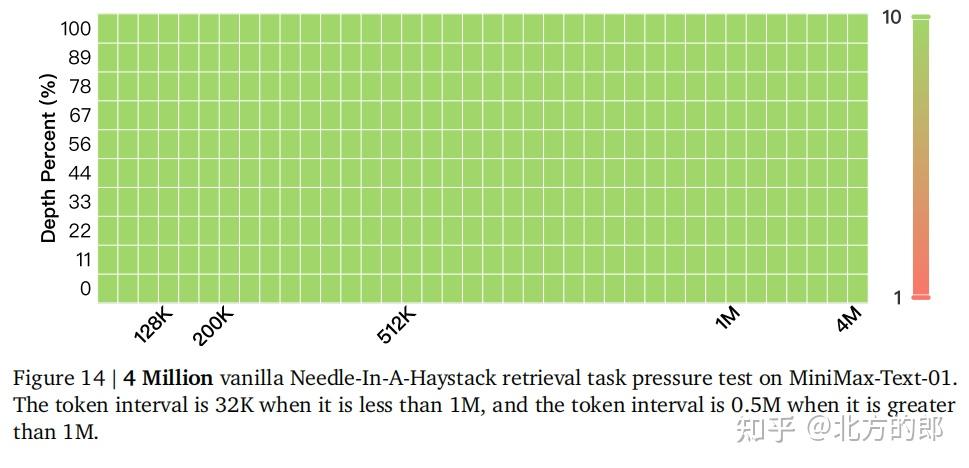

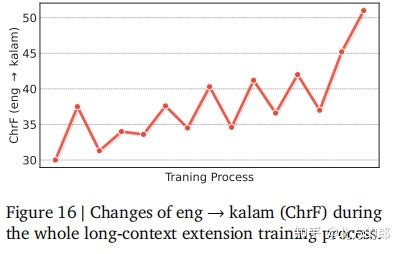

4.2.3 长上下文评估

MiniMax-01在长上下文扩展过程中,使用更复杂的任务评估模型的中间检查点。尽管NIAH(Needle in a Haystack)任务在早期训练阶段就达到了峰值性能,但MiniMax-01通过引入更具挑战性的任务,确保了模型在长上下文处理能力上的持续提升。

5. 后训练

MiniMax-01的后训练框架是其在实际应用中表现出色的关键。通过监督微调(SFT)、离线和在线强化学习(RL),MiniMax-01在多个维度上进行了对齐和优化,确保了模型在长上下文处理、真实场景应用和安全性方面的卓越表现。以下是对后训练过程的详细解析。

5.1 提示收集

MiniMax-01的提示收集过程涵盖了数百万个多样化的高质量查询,这些查询来自多个来源,并经过精心筛选和分类。提示集涵盖了长上下文、编程、数学、逻辑推理、创意写作、函数调用、常识问答和安全相关场景等多个领域。通过复杂的过滤机制,MiniMax-01确保了提示集的多样性和难度分布的合理性。

5.2 奖励模型

MiniMax-01的奖励模型从四个关键维度评估响应,确保模型输出与人类价值观的一致性:

- 正确性:

对于可以严格验证的响应,MiniMax-01实施了严格的评估系统。对于数学和推理任务,模型生成二元奖励信号,基于答案的一致性进行评估。编程解决方案在安全的沙箱环境中进行测试,性能指标基于测试用例的成功率。

- 真实性:

MiniMax-01采用了一个验证管道,评估响应的真实性。该过程包括系统响应采样、陈述分解和聚类、众包验证以及使用高级语言模型进行自动比较,生成真实性分数。

- 帮助性:

评估框架通过确定性和概率性方法评估响应对用户指令的遵从性。MiniMax-01实施了自动规则约束验证系统,并结合人类评估关键指标,包括连贯性、深度、上下文相关性和风格适当性。最终帮助性分数通过加权评分系统结合多个评估信号。

- 无害性:

基于宪法AI原则,MiniMax-01开发了评估标准,涵盖安全协议、内容适当性和法律合规性。评估系统利用精心校准的提示,并通过早期版本的MiniMax-Text-01提供标准化安全评估。

5.3 监督微调(SFT)

MiniMax-01的SFT数据集构建涉及多阶段过程,利用领域专家模型通过迭代SFT和RL周期生成高质量响应。通过拒绝采样,模型生成多个响应变体,并根据奖励层次选择最佳示范。响应选择过程进一步结合了n-gram和语义相似性过滤器,确保训练数据的多样性和高质量。

5.4 强化学习(RL)

MiniMax-01的强化学习分为离线和在线两个阶段,旨在进一步提升模型在多样化提示分布下的表现。

5.4.1 离线强化学习

MiniMax-01采用直接偏好优化(Direct Preference Optimization, DPO)进行离线RL,优化模型在多样化提示分布下的表现。实验表明,使用SFT训练过的提示和未训练但同源的提示在性能上差异不大,因此MiniMax-01采用SFT训练过的提示进行离线RL。

5.4.2 在线强化学习

在线学习在样本效率和跨领域泛化能力上优于离线学习。MiniMax-01的在线RL强调提示多样性,并优先选择中等成功率的提示以最大化信息增益。通过修改的组相对策略优化(Group Relative Policy Optimization, GRPO),MiniMax-01实现了以下关键创新:

- 重要性采样权重裁剪:

通过额外的裁剪操作,MiniMax-01调节了重要性采样的幅度,减少了噪声传播。

- KL散度优化:

通过理论分析方差-偏差权衡,MiniMax-01重新制定了KL散度项,进一步稳定了梯度行为。

- 平衡优势估计:

确保正负样本之间的奖励贡献均衡,特别是在分布倾斜的场景下,保持了训练动态的稳定性。

5.5 安全对齐

MiniMax-01的安全对齐贯穿SFT和RL阶段,通过以下关键组件确保模型的无害性和帮助性:

- 训练数据构建:

MiniMax-01构建了高质量的对齐训练数据,涵盖广泛的安全场景。通过安全类别特定提示、真实用户数据收集和提示增强,模型暴露于多样化的安全相关查询中。

- 无害奖励模型:

MiniMax-01采用了一个基于详细安全规则的无害奖励模型,生成安全且适当的响应。通过将帮助性原则整合到安全规则中,模型能够在提供安全响应的同时保持实用性。

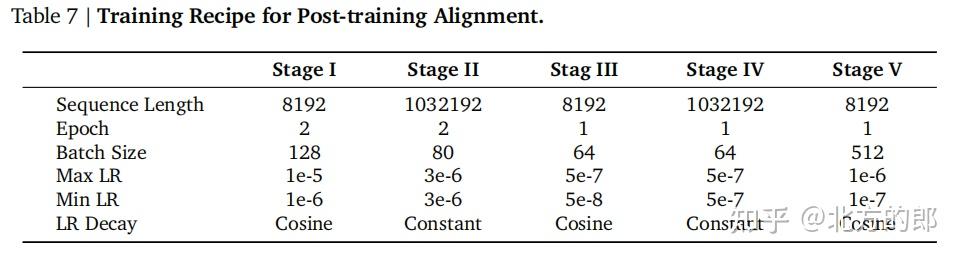

5.6 长上下文适应的训练方法

MiniMax-01提出了一种系统的多阶段训练方法,以增强模型处理长上下文的能力,同时保持短上下文任务的性能。训练方法分为五个阶段:

- 初始短上下文训练:

第一阶段实施SFT,序列长度限制为8192 token,建立模型在标准长度查询和响应上的基础能力。

- 扩展上下文训练:

第二阶段将序列长度扩展到1,032,192 token,涵盖多样化的序列长度,促进模型对长上下文的全面适应。

- 短上下文偏好优化:

第三阶段将序列长度恢复为8192 token,实施直接偏好优化(DPO),确保模型在常规上下文大小上的最优性能。

- 长上下文偏好优化:

第四阶段通过DPO强化长上下文处理能力,使用1,032,192 token的序列长度进行训练。

- 在线强化学习:

第五阶段实施短上下文在线强化学习,序列长度为8192 token,进一步提升模型在短上下文任务上的表现。

5.7 学术基准

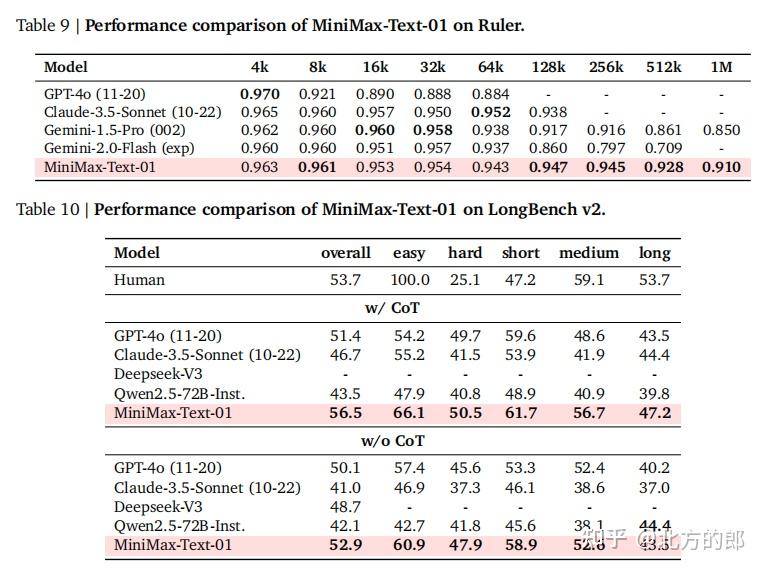

MiniMax-01在多个学术基准上进行了全面评估,展示了其在长上下文检索、理解、长上下文学习和知识请求等方面的卓越能力。

5.7.1 核心基准

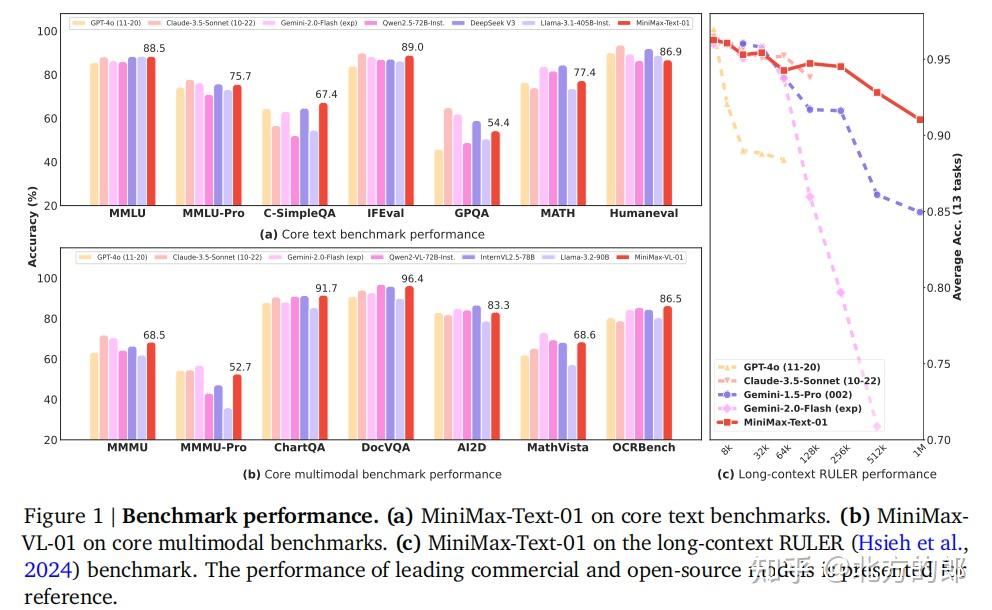

MiniMax-01在MMLU、MMLU-Pro、SimpleQA、C-SimpleQA、IFEval、Arena-Hard、GPQA、DROP、GSM8k、MATH、MBPP+和HumanEval等基准上表现优异,尤其在中文知识边界和数学推理任务上展现了强大的能力。

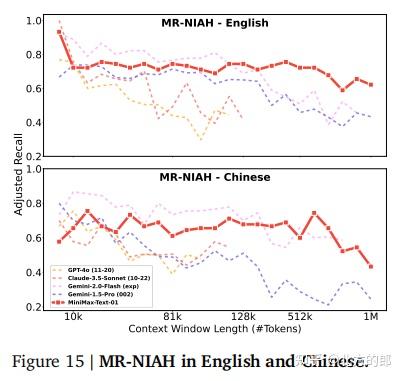

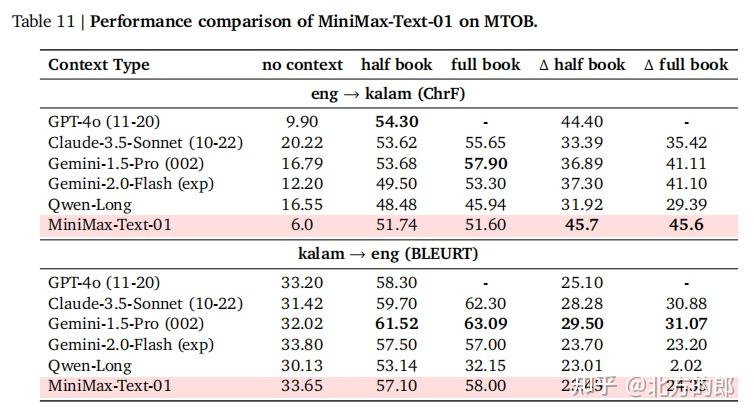

5.7.2 长上下文基准

MiniMax-01在长上下文检索、理解和学习任务上进行了深入评估。通过多轮针在草堆中(MR-NIAH)任务,模型展示了在长达100万token的上下文窗口下的强大记忆能力。在Ruler和LongBench-V2等长上下文问答数据集上,MiniMax-01在复杂推理任务中表现尤为出色。

5.7.3 长上下文学习

MiniMax-01在MTOB(Machine Translation from One Book)任务中展现了强大的上下文学习能力。尽管训练数据中仅包含少量Kalamang相关内容,模型在仅通过上下文学习后,成功实现了从英语到Kalamang的翻译任务。

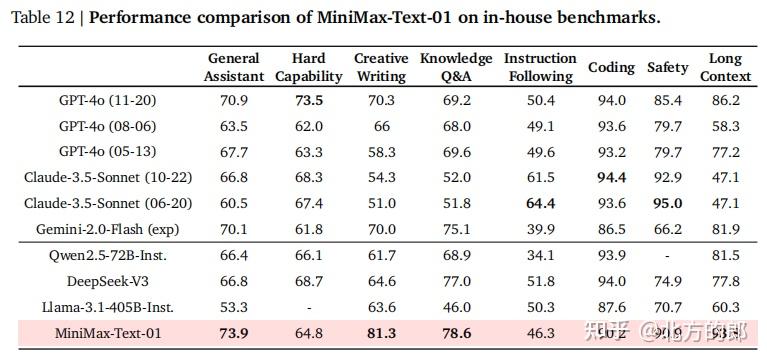

5.8 用户参与评估

MiniMax-01通过用户参与评估,进一步优化了模型在真实场景中的表现。通过自动评估和专家人工评估,MiniMax-01在通用助手能力、知识问答、创意写作、硬能力、指令遵循、编码、安全性和长上下文处理等方面展现了卓越的性能。

5.8.1 内部评估

MiniMax-01的内部评估涵盖了多个维度,包括通用助手能力、知识问答、创意写作、硬能力、指令遵循、编码、安全性和长上下文处理。评估结果表明,MiniMax-01在真实用户交互场景中表现优异,尤其在创意写作和知识问答任务上展现了强大的能力。

5.8.2 搜索工具的使用

MiniMax-01通过搜索工具的使用,显著提升了模型在实时信息获取和精确回答上的能力。通过预定义搜索场景和精心构建的SFT数据集,MiniMax-01在搜索决策边界上进行了校准,确保了模型在多样化查询中的高效表现。

6. 视觉语言模型

MiniMax-VL-01是MiniMax-01的视觉语言版本,通过集成图像编码器和图像适配器,模型具备了强大的视觉理解能力。MiniMax-VL-01的训练过程分为四个阶段,逐步提升了模型在多模态任务中的表现。以下是对视觉语言模型的详细解析。

6.1 多模态数据

MiniMax-VL-01的训练数据是其成功的基础。为了确保模型在多模态任务中的优异表现,MiniMax-01在数据选择、数据格式和数据混合策略上进行了精心设计和优化。

6.1.1 图像-标题数据

为了预训练视觉编码器,MiniMax-VL-01从互联网来源收集并过滤了大量的图像-标题对。模型使用6.94亿个独特的图像-标题对进行训练。为了提升数据质量,MiniMax-VL-01获取了1.8亿张图像的精细标题,并在训练过程中随机采样原始和精细标题,确保数据的多样性和高质量。

6.1.2 描述数据

描述数据在现有的视觉语言模型中被证明对模型训练具有显著效用。MiniMax-VL-01从开放资源(如Common Crawl)中收集了1亿张图像,每张图像都配有一个精细的描述。这些描述平均包含约300个文本token,为模态对齐和增强理解提供了强大的资源。

6.1.3 指令数据

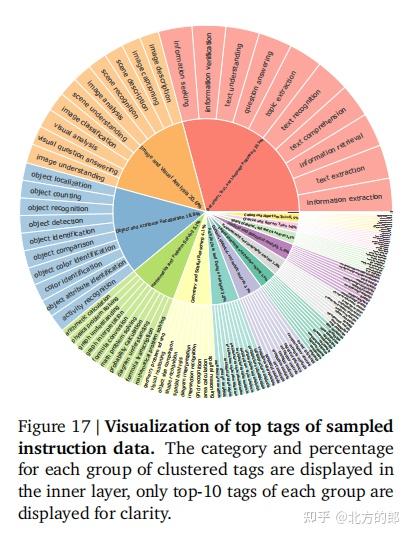

为了训练MiniMax-VL-01,模型构建了一个全面的指令数据集,涵盖了广泛的视觉相关任务,如文本提取、对象定位和几何问题求解。数据集生成过程优先考虑多样性和真实性,确保指令捕捉到不同复杂度和语言风格的任务。

6.1.4 数据分布

为了展示多模态数据的多样性,MiniMax-VL-01从指令数据中均匀采样了100万个图像-指令对,并使用另一个视觉语言模型为每对分配一个简洁的标签(如对象定位)。分析结果显示,这些标签涵盖了约5万个独特的标签,其中前2817个标签出现次数超过10次。这些标签被进一步分为14个主要类别,如图像分类、对象检测和视觉问答等。

6.2 架构

MiniMax-VL-01的架构设计遵循了“ViT-MLP-LLM”范式,这一范式在众多多模态大语言模型(MLLM)中得到了广泛应用。架构主要由三个部分组成:视觉Transformer(ViT)、两层MLP投影器和MiniMax-Text-01模型。

6.2.1 整体架构

MiniMax-VL-01的架构包括:

- 视觉编码器:一个303M参数的ViT,用于视觉编码。

- 图像适配器:一个两层MLP投影器,随机初始化,用于图像适配。

- 语言模型:MiniMax-Text-01作为基础大语言模型(LLM)。

MiniMax-VL-01采用动态分辨率策略,根据预定义的网格配置列表调整输入图像的分辨率,范围从336×336到2016×2016。调整后的图像被分割成非重叠的336×336 patch,每个patch和缩略图分别编码,并将编码特征连接起来构建全面的图像特征表示。

6.2.2 视觉编码器

MiniMax-VL-01采用轻量级的ViT-L/14作为视觉编码器的基础结构,并从头开始训练。输入图像张量首先通过卷积层提取离散patch,然后附加绝对位置嵌入。结果张量通过一系列多头残差注意力块传递,有效捕捉图像中的复杂细节和相互关系。

MiniMax-VL-01使用对比学习来增强图像-标题对之间的对齐,同时减少非对应对的对齐。具体来说,模型遵循CoCa方法,通过额外的解码器和图像-文本交叉注意力机制增强图像-文本对比学习。网络通过对比损失和交叉熵损失联合优化。

ViT-L/14模型首先在224×224分辨率下训练370亿个图像-标题对,然后在336×336分辨率下微调12亿对。在这两种分辨率下,标题被截断为76个token。ViT-L/14编码器在ImageNet-1K数据集上的零样本分类准确率达到80.55%。

6.3 训练方法

MiniMax-VL-01的训练分为四个阶段,逐步提升模型在多模态任务中的表现。

6.3.1 模态对齐

在第一阶段,MiniMax-VL-01的主要目标是实现视觉和文本token之间的对齐,使模型能够为给定图像生成适当的标题。为此,模型更新图像适配器和视觉编码器的权重,优化其在多模态任务中的表现。此阶段使用了800亿个token的图像描述数据。

6.3.2 视觉理解增强

在第二阶段,MiniMax-VL-01进行标准的指令微调,更新所有模型参数,以对齐模型输出与人类指令,并增强其在多样化视觉理解任务中的表现。此阶段使用了4200亿个多模态token,结合MiniMax-Text-01的后训练数据,比例为20:1,确保语言建模能力的同时,模型获得新的多模态能力。

6.3.3 用户体验增强

在第三阶段,MiniMax-VL-01进一步增强了模型在真实场景和复杂用户输入中的表现。模型使用从常见应用程序中收集的复杂多模态数据进行训练,对话经过精心标注,模拟真实用户输入,确保提供准确、有帮助和多样化的响应。此阶段使用了448亿个多模态token,训练一个epoch。

6.3.4 偏好优化

在第四阶段,MiniMax-VL-01使用直接偏好优化(DPO)进一步提升模型表现和用户体验。训练数据集包括4万个图像-文本对,通过以下过程构建:

- 提示选择:从指令数据和真实用户交互数据中筛选提示,涵盖广泛的一般场景和特定问题。

- 响应生成:通过多种策略生成响应,包括变化采样温度、图像弱化和引入幻觉或错误。

- 奖励分配:使用MiniMax-Text-01作为评估者,设计多维度评估标准,系统评估提示、真实答案和生成响应之间的关系。

- 对构建:根据评估结果,选择最高分响应作为正样本,最低分响应作为负样本,丢弃差异不显著的对。

此外,MiniMax-VL-01还包含了大量纯文本对,以防止过拟合并保持模型的泛化能力。

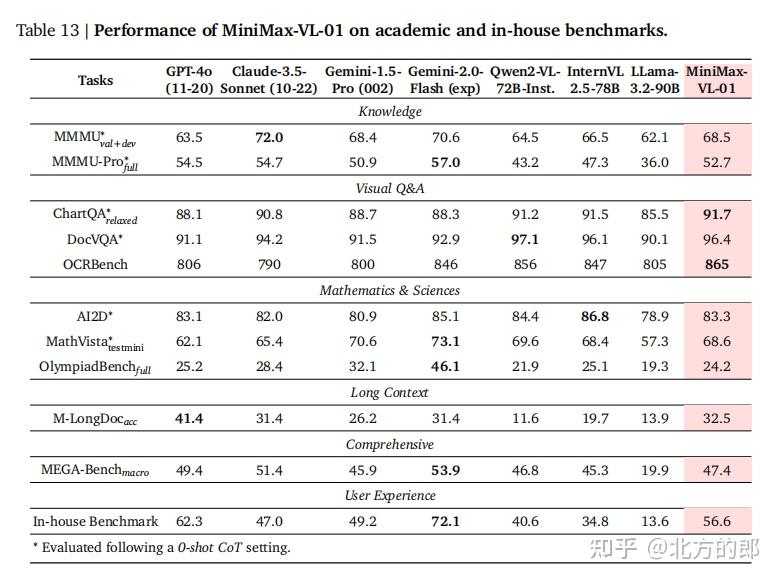

6.4 基准测试

MiniMax-VL-01在多个基准上进行了全面评估,展示了其在知识、视觉推理、数学、科学、长上下文处理和用户体验等方面的卓越能力。

6.4.1 常见下游任务

在标准视觉语言下游任务中,MiniMax-VL-01表现优异,尤其在视觉问答任务上展现了强大的能力。然而,模型在高级数学推理任务(如OlympiadBench)上仍面临挑战。

6.4.2 长上下文处理

MiniMax-VL-01在MMLongBench-Doc基准上评估了其长上下文理解和检索能力。结果显示,模型在单页和跨页子集上表现优异,尽管与GPT-4o-11-20相比仍存在一定差距。

6.4.3 综合基准

在MEGA-Bench基准上,MiniMax-VL-01展现了强大的综合能力,尤其在知识和编码任务上表现突出。然而,模型在复杂任务(如规划和度量评估)上仍需进一步提升。

6.4.4 内部用户体验基准

MiniMax-VL-01开发了一个内部用户体验基准,涵盖90个多样化的图像相关任务,每个任务都设计了具有挑战性的指令。最终测试集包括524个精心标注的中英文样本,模型在中文任务上表现尤为出色。

7. 结论与未来工作

MiniMax-01系列模型在标准基准测试中表现优异,尤其是在长上下文处理上展现了强大的能力。通过创新的闪电注意力机制和优化的硬件利用,MiniMax-01成功将上下文窗口扩展了一个数量级,为未来的AI模型开辟了新的道路。尽管MiniMax-01在通用语言和视觉语言任务上表现出色,但仍有一些局限性需要进一步探索,如长上下文评估、模型架构优化和复杂编程任务的提升。

MiniMax-01的发布标志着AI模型在长上下文处理上的重大突破,未来将继续推动这一领域的发展,为更复杂的AI应用奠定基础。