作者:潘梓正,莫纳什大学博士生 主页:zizhengpan.github.io

原文链接:https://zhuanlan.zhihu.com/p/685943779

最近看到有些问题[1]说为什么Transformer中的FFN一直没有大的改动。21年刚入学做ViT的时候就想这个问题,现在读博生涯也快结束了,刚好看到这个问题,打算稍微写写,

也算是对这个地方做一个小总结吧。

1. Transformer与FFN

Transformer的基本单位就是一层block这里,一个block包含 MSA +

FFN,目前公认的说法是,

• Attention 作为token-mixer做spatial interaction。

• FFN

(又称MLP)在后面作为channel-mixer进一步增强representation。

从2017至今,过去绝大部分Transformer优化,尤其是针对NLP

tasks的Efficient Transformer都是在Attention上的,因为文本有显著的long

sequence问题。安利一个很好的总结Efficient Transforme ...

最近,无论是 OpenAI 的 Sora 模型,还是 Stability AI 的 Stable

Diffusion 3 ,都让我们看到了生成模型方面的突破。这也让我们不禁思考:AIGC

领域的微积分时刻是否已经到来?

3月2日晚8点,青稞社区策划推出【青稞Panel】第一期,并邀请到DeepFaceLab(累计60,000

+⭐️)作者小黑兔、InstantID(huggingface

space周榜第一)作者王浩帆、剑桥大学计算机系在读博士Andi Zhang和VBench

第一作者、南洋理工大学MMLab在读博士黄子琪参与,共同探讨《Sora迷思,AIGC的微积分时刻?》。

alt text

参与嘉宾

王浩帆,CMU(卡耐基梅隆)硕士毕业,InstantX成员,代表工作InstantID(huggingface

space周榜第一,Yann Lecun转发点赞),Score-CAM(累计1000+ google

citation),发表过 NeurIPS、CVPR、ICCV、3DV 等多个领域顶级会议。

Andi

Zhang,剑桥大学计算机数学双硕士,剑桥大学计算机系博士生 ...

作者:李博杰, Logenic AI

联合创始人、中科大与MSRA联培计算机博士、华为天才少年

个人主页:https://01.me/

原文链接:https://zhuanlan.zhihu.com/p/681283469

(本文是 2024 年 1 月 6 日笔者在知乎首届 AI

先行者沙龙上的演讲实录)

非常荣幸能够认识大家,非常荣幸能够来知乎 AI

的先行者沙龙来做分享,我是李博杰,Logenic AI 联合创始人。我们知道目前 AI

Agent 非常火,比如说参加路演 70 多个项目,一半多都是跟 AI Agents

相关的项目, AI Agents

的未来会是什么样子呢?它未来应该是更有趣还是更有用呢?

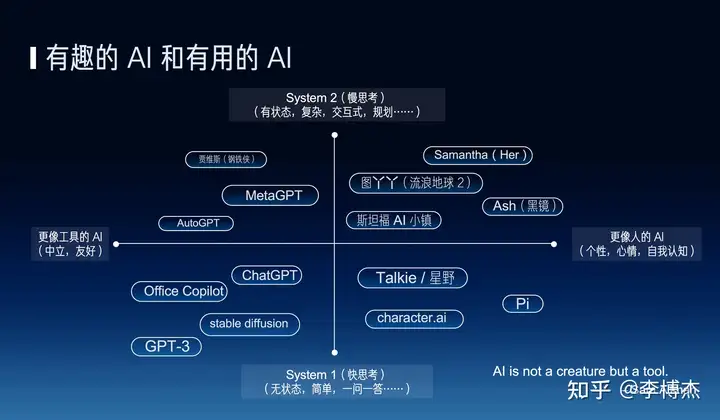

我们知道 AI 的发展目前一直有两个方向,一个是有趣的 AI,一个是更像人的

AI,另外一个方向就是更有用的 AI,也就是 AI

应该更像人还是更像工具呢?其实是有很多争议的。比如说 OpenAI 的 CEO Sam

Altman 他就说 AI

应该是一个工具,它不应该是一个生命,但是我们现在所做的事正好相反,我们现在是让

AI 其实更像人,其实很多科幻电影里的 AI ...

阿里巴巴通义实验室

自然语言智能团队介绍

阿里巴巴通义实验室,自然语言智能团队主要负责通义系列大模型研究与产品落地。其中我们智能对话与服务技术团队,以大模型研究和应用为中心,以AI智能体为核心交互形态,推进大模型的大规模商业化应用,主要技术包括:

(1)AI Agents

(2)个性化大模型

(3)多模态等

过去三年发表40+篇国际顶会论文,包括ICML、EMNLP、ACL、CVPR等各领域顶会;主要技术研究方向包括:

1、通义星尘-个性化大模型,类CharacterAI角色扮演应用,打造更好的AI情感陪伴智能体应用;

2、ModelScope-Agent,开源的可定制化的通用Agent框架和Agent智能体大模型;

3、多模态mPLUG大模型系列,包括mPLUG、mPLUG-2、mPLUG-owl等工作。

团队Github:

https://github.com/X-PLUG

招聘岗位

Research Intern /

算法专家(P6/P7)

坐标:杭州、北京 类型:实习/社招

岗位职责

1、负责Agent框架和Agent底座的优化,包括但不限于multi-agent应用,pl ...

周末加班干活了~

img

1234Project page: https://humanaigc.github.io/animate-anyone/Code: https://github.com/HumanAIGC/AnimateAnyoneArxiv: https://arxiv.org/pdf/2311.17117.pdfYoutube Video: https://www.youtube.com/watch?v=8PCn5hLKNu4

前言

Animate Anyone是阿里巴巴通义实验室XR

Lab最新推出的成果,只需要单张图片和Openpose动作就可以让图片动起来并保持稳定性。

具体来说,Animate Anyone是基于Diffusion model

(扩散模型结构)来进行pose2video的生成,通过如2D

openpose的姿态骨架skeleton,来引导(guide)网络生成和参考图像reference

image一致的角度动态效果。

Animate

Anyone也是第一个在Pose2Video领域生成角色动画达到80分成绩的方法。Twitter上各 ...