减论

(ReductTheory):传递人工智能算法科普教育的减约理解,提升信息效率及认知维度。

大家好,这里是减论为您带来的5分钟极减阅读CVPR24 best

paper《Generative Image Dynamics》,生成式图像动态。

12Paper:Generative Image DynamicsarXiv:https://arxiv.org/abs/2309.07906

CVPR今年2篇best

paper都给了图像生成模型,可见社区对生产式模型的关注度还是空前高涨的。这篇文章《Generative

Image

Dynamics》GID重点解决的是某种特定类型的动态视频的生成:图像全局的自然摇曳,例如下图中由风引起的树叶、花朵、灯笼、烛火的摆动,甚至是猫咪的呼吸导致的腹部起伏。

原文本质上是对《Image-Space Modal Bases for Plausible Manipulation of

Objects in

Video》[0]这篇2015年TOG的深度学习化改造。原文GID和这篇TOG文章从效果上做了几乎一致的事情,形成自然摇曳的目标(或图像),用 ...

减论

(ReductTheory):传递人工智能算法科普教育的减约理解,提升信息效率及认知维度。

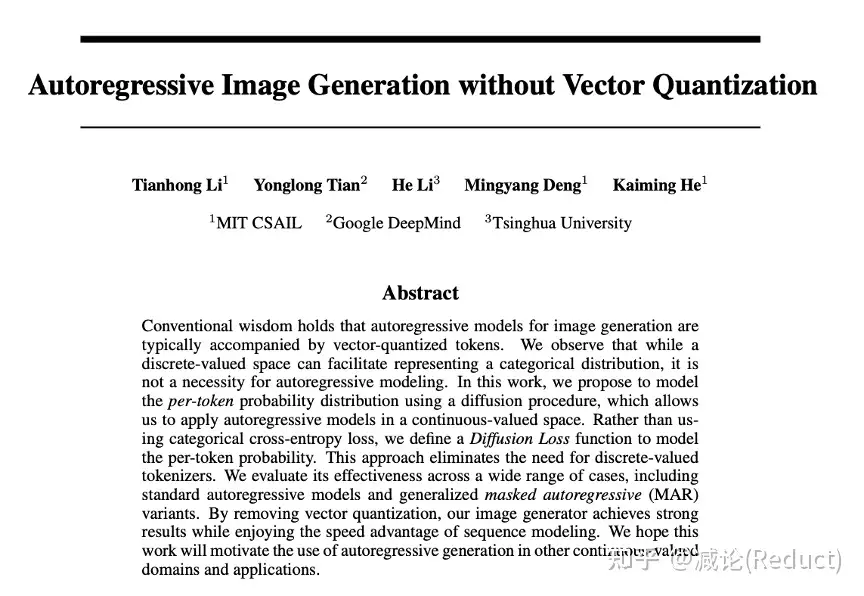

大家好,这里是减论为您带来的5分钟极减阅读《Autoregressive Image

Generation without Vector

Quantization》,即无向量量化的自回归图像生成模型

12Paper:Autoregressive Image Generation without Vector Quantization ArXiv:https://arxiv.org/abs/2406.11838

众所周知,kaiming出品,必属精品。今天,让我们花5分钟时间来领略一下kaiming团队在图像自回归生成领域的一大力作:MAR

+ Diffusion Loss。一作是li tianhong博士。

这篇工作的故事线是希望移除自回归式的图像生成模型(Autoregressive Image

Generation,AIG)对向量量化(vector

quantization,VQ)的依赖,也就是人们常说的codebook,有限向量码表。

AIG为什么会对codebook有所 ...

如何评估多智能体系统在包含空间、因果和时间约束的复杂依赖性中的表现?来自浙江大学朱霖潮团队的研究人员在

ACL 2024 findings 中构建了一个新的基准测试 VillagerBench。VillagerBench

包含了设计用来测试多智能体协作的各个方面的多样化任务,并引入了有向无环图多智能体框架(VillagerAgent),以解决复杂的智能体间依赖性并提高协作效率。

VillagerAgent

包含了四大核心组件:任务分解器、智能体控制器、状态管理器和基础智能体,就像是

AI 的指挥家,将个体行动转化为协作的杰作。

VillagerBench:智能体互动和学习的虚拟沙盒 🤹。

TaskManager:任务图的策划者,确保任务按计划进行,智能体了解情况

📊。

DataManager:知识的守护者,紧握所有数据牌 🗃️。

GlobalController:全局监督者,确保每个智能体完美发挥其角色

🎯。

在 VillagerBench 上的实证评估表明,VillagerAgent

在减少幻觉和提高任务分解效率方面,超越了现有的 AgentVerse

模型。同时, ...

Agentic

AI:超越基础模型的下一代 AI — 来自吴恩达的洞察

“与其争论哪些工作才算是真正的 Agent,不如承认系统可以具有不同程度的

Agentic 特性。” —— 吴恩达

2024年 Snowflake 峰会开发者日上,人工智能领域的领军人物吴恩达 (Andrew

Ng) 发表了题为“AI 代理工作流及其推动 AI 进展的潜力 (How AlAgentic

workflows could drive more Al progress than even the next generation of

foundation models)”的演讲,为我们揭开了 Agentic AI

的神秘面纱,并指出这可能是比下一代基础模型更具潜力的 AI 发展方向。

Agentic AI :从

Agent 到 Agentic,开启 AI 新纪元

近年来,大型语言模型 (LLM) 如 GPT-3、GPT-4

等的出现,为人工智能领域带来了前所未有的突破。然而,传统的 LLM

交互方式更像是一种“非代理型工作流程 (Non-agentic workflow

(zero-shot))”, ...

浙江大学招收访问学者、研究助理、博士后、硕士和博士生

Monash University招收1-2名博士生

ZIP Lab介绍

ZIP Lab

是一个国际性的研究实验室,位于杭州和墨尔本。我们的主要研究重点是为边缘应用开发高效的机器学习系统,特别是在大型语言模型和多模态大模型方面。自2021年成立以来,实验室凭借其才华横溢的成员迅速取得了发展。

有关我们团队成员和论文的更多信息,请访问实验室主页:

https://ziplab.github.io/

我们正在积极招聘浙江大学的访问学者、研究助理、博士后、硕士和博士生。此外,我们还在 Monash

University

招收1-2名博士生 ,将由资深教授共同指导。我们期待在学术界影响力和工业界落地都取得突破,欢迎您的加入!

PI简介

Bohan Zhuang是ZIP

Lab的负责人。他于2018年在阿德莱德大学获得博士学位,并在澳大利亚机器人视觉中心担任高级研究员。从2020年至今,他担任Monash

University信息技术学院的长聘助理教授,该校在2025年QS全球排名第37位。2023年,他获得了国家优 ...

大型语言模型(LLMs)尽管在处理一般任务上表现出色,但在编程、数学等特定领域依然存在不足。传统的方法通常需要大量数据和计算资源,且容易导致原有能力的丧失。

来自香港大学和腾讯 ARC 实验室的研究者在 ACL

2024最新成果中提出了一种新的 LLM 后训练方案:LLAMA PRO

,旨在通过扩展Transformer块来优化大型语言模型(LLMs)的性能。LLAMA PRO

通过在预训练后的模型中添加新的Transformer块并进行调整,有效提高了模型的领域知识,同时保持了其通用能力。

实验表明,LLAMA PRO

在编程、数学等任务中表现优异,且其指令跟随版本(LLAMA PRO -

INSTRUCT)在各种基准测试中表现出色。方法的核心在于,通过块扩展技术,只对新添加的块进行调整,而冻结原有块,从而在有效注入新知识的同时,保留模型的初始能力。

123paper:LLaMA Pro: Progressive LLaMA with Block ExpansionarXiv:https://arxiv.org/pdf/2401.02415code:https://github ...

随着大模型规模日益增长,微调整个模型的开销逐渐变得难以接受。来自北京大学人工智能研究院的孟繁续博士等人,通过对预训练模型的权重进行奇异值分解,将其中最重要的参数用于初始化一个名为

PiSSA 的适配器。微调这个适配器就能近似达到直接训练完整模型的效果。

PiSSA 使用与 LoRA 完全相同的架构,因此直接继承 LoRA

的大部分优点。但是有着不同的初始化方式,PiSSA

使用主奇异值奇异向量进行初始化 。实验表明,PiSSA 在多个模型和任务上比

LoRA 收敛更快,最终效果更好,唯一的代价就是需要几秒的初始化过程。

同时,PiSSA 能使4bit量化误差减小约1/5,有单卡3090就能训

LLaMA-3-8B,在单卡A100就能训 LLaMA-3-70B,训练效果更是显著超越

QLoRA。目前,PiSSA

已经合并到huggingface/peft项目的主分支,仅需设置一个参数就能开始训练。

1234paper:PiSSA: Principal Singular Values and Singular Vectors Adaptation of Large Language M ...

作者:张俊林,新浪微博新技术研发负责人

声明:本文只做分享,版权归原作者,侵权私信删除!

原文:https://zhuanlan.zhihu.com/p/700622253

以下内容是5月15日甲子光年圆桌论坛讨论内容,涉及Scaling

Law、合成数据与“半合成数据”、与Transformer不同的新模型结构、MOE及Long

Context等问题。

一、是否相信Scaling Law?

王艺 :围绕Scaling

Law有很多的争议,有些人是坚定的信仰者,觉得只要堆数据、堆算力就能带领我们达到AGI;但是也有人认为你无限堆数据和算力并不能无限提升模型的性能,它其实会慢慢趋向于一个固定的值。那你是Scaling

Law的坚定信仰者吗?

张俊林:Scaling

Law其实是个经验公式,最初是OpenAI在2020年提出来的,现在大家遵循的应该是DeepMind在22年提出的Chinchilla

Scaling Laws(Chinchilla Scaling

Laws:为了使模型达到最佳性能,模型参数量应与训练集的大小成等比例扩张。),尽管它被称为Law,但它是通过大量的实验来得出 ...

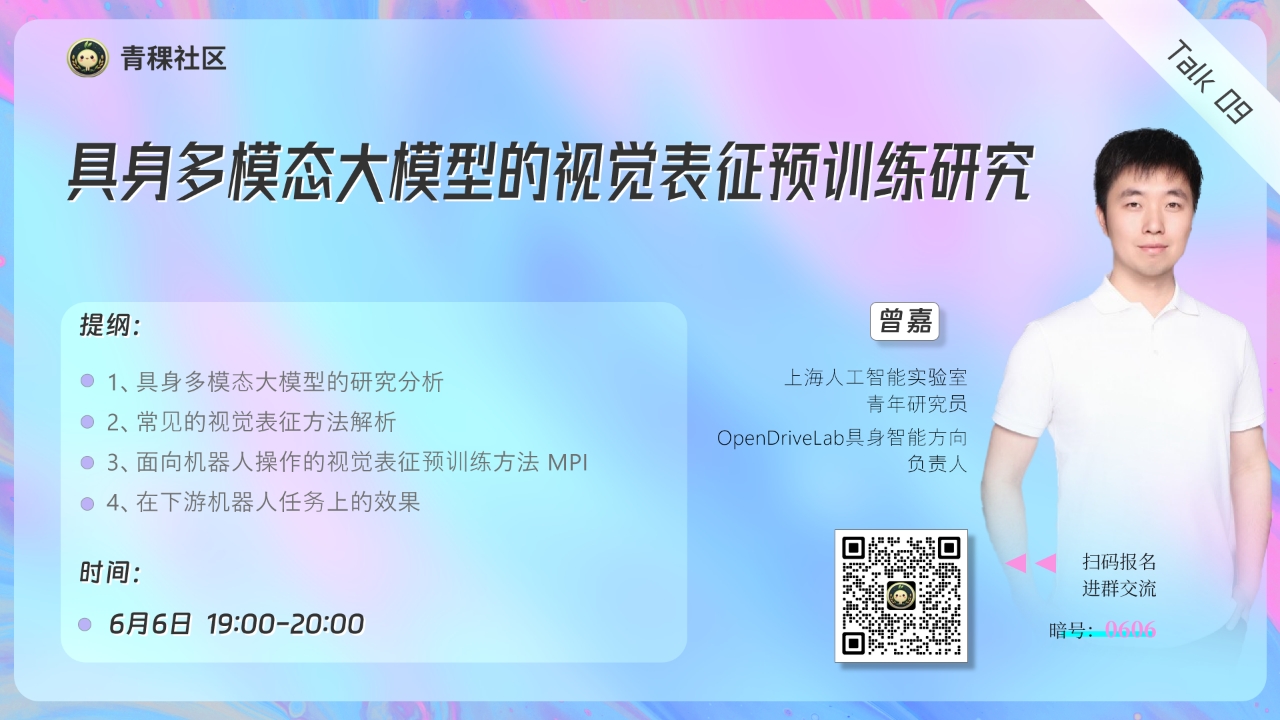

对于具身多模态模型而言,良好的视觉表征能力是其理解环境的基础,它的效果很大程度上依赖于视觉表征的质量和表现力,因此视觉表征预训练方法尤为重要。考虑到机器人数据的稀缺性,可利用大规模人类视频数据集来提取可泛化特征,用于视觉驱动的运动控制策略学习。

上海人工智能实验室青年研究员,OpenDriveLab具身智能方向负责人曾嘉等人在最新中稿

RSS 2024 的论文成果中,提出了一种视觉表征预训练方法LearningManipulation

by Predicting Interaction (MPI)。

MPI

通过预测交互帧以及定位交互对象,使模型对于“如何交互”和“在哪里交互”有了更好地理解,增强了编码器捕捉操作过程中的行为模式及交互特征的能力。在多个下游机器人任务上,MPI

相比于 R3M、MVP、Voltron 等表征学习方法取得了显著的提升。

6月6日晚7点,青稞社区组织【青稞Talk】第九期,上海人工智能实验室青年研究员、OpenDriveLab具身智能方向负责人曾嘉博士,将直播分享《具身多模态大模型的视觉表征预训练研究》。

Talk信息

分享嘉宾

曾嘉,上海人工 ...

近年来,文生视频的发展取得了巨大的进步。文生视频一般是通过一段文本来驱动视频生成。在定制化生成的任务下,用户往往想要指定生成某一特定主体的视频。

然而仅仅使用文本不足以描述主体的所有特征,因此来自南洋理工大学 MMLab

实验室和上海人工智能实验室的研究人员,在 CVPR 2024

的最新成果中,提出了一种由文本和图像提示共同驱动的视频生成方法:VideoBooth。

123paper:VideoBooth: Diffusion-based Video Generation with Image PromptsarXiv:https://arxiv.org/pdf/2312.00777code:https://github.com/Vchitect/VideoBooth

文本提供一些场景和动作的描述,而图像提供了主体的外貌。VideoBooth通过在粗粒度和细粒度两个维度把图像提示嵌入到Diffusion模型的方式,在主体一致性上取得了较好的结果。

5月29日晚7点,青稞社区组织【青稞Talk】第八期,南洋理工大学

MMLab

实验室在读博士姜瑜铭,将直播分享《VideoBoot ...